:bangbang: :new: NVIDIA H200 已发布,并在 TensorRT-LLM 上进行了优化。了解更多关于 H200 和 H100 的对比,请点击这里: H200 在 Llama2-13B 上使用 TensorRT-LLM 实现了近 12,000 tokens/秒

H100在TensorRT-LLM中的性能是A100的4.6倍,在100毫秒内达到10,000 tok/s的首个令牌

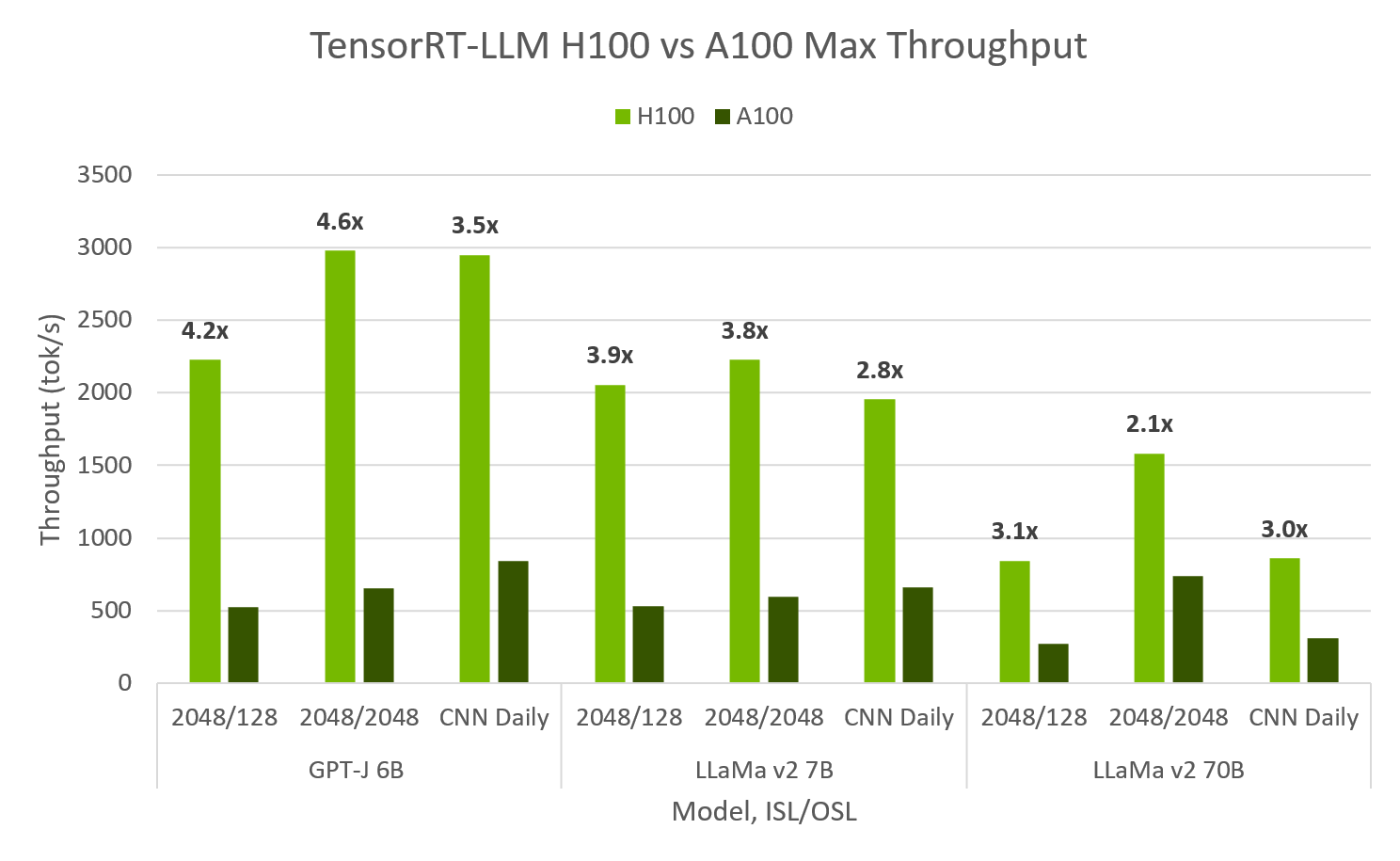

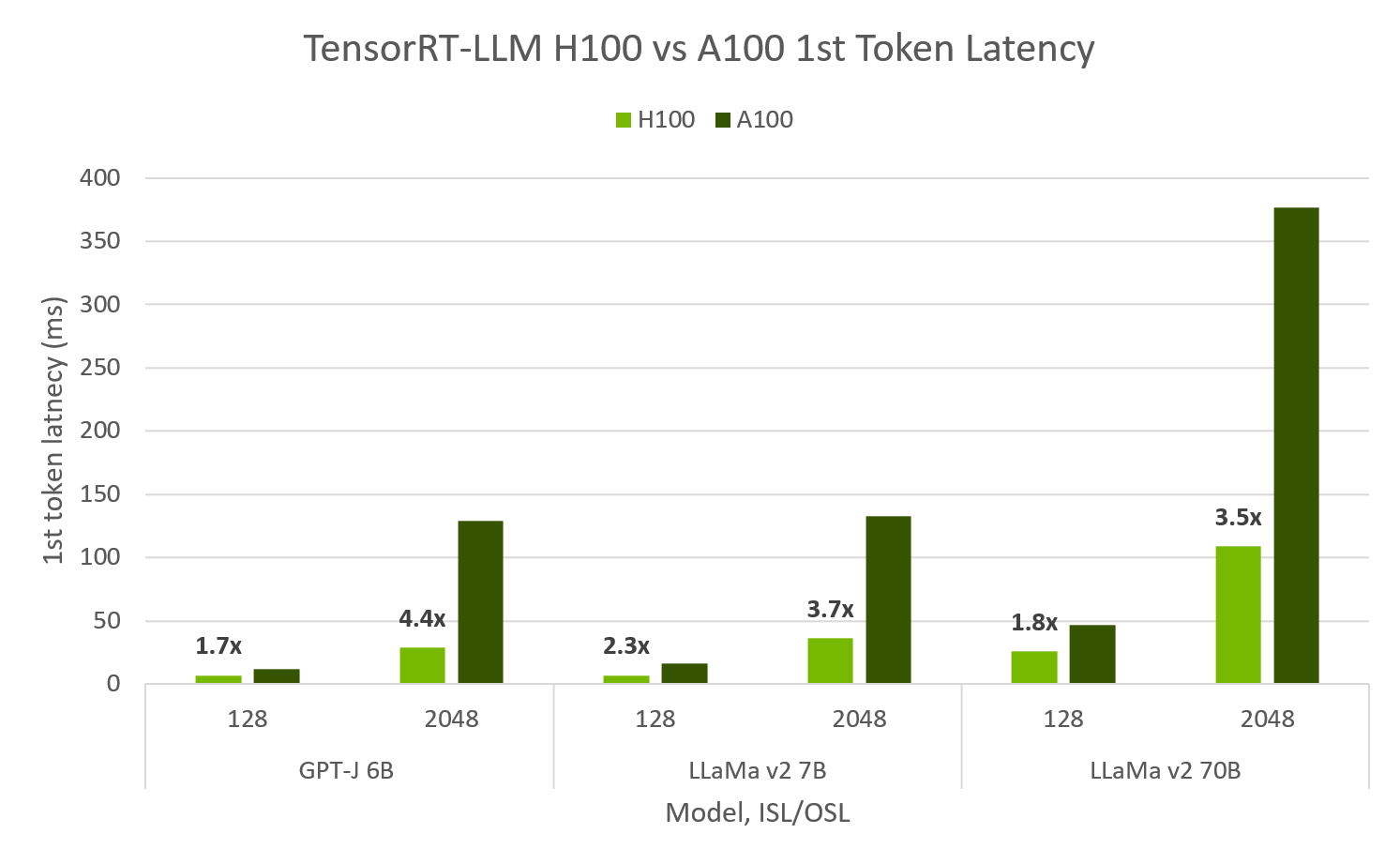

在Hopper和Ampere上评估的TensorRT-LLM显示,H100 FP8的最大吞吐量比A100高出4.6倍,首次令牌延迟快4.4倍。H100 FP8在64个并发请求的峰值吞吐量下能够实现超过10,000个输出令牌/秒,同时保持首次令牌延迟为100毫秒。对于最小延迟应用,TRT-LLM H100可以实现首次令牌延迟小于10毫秒。

TensorRT-LLM 在 H100 和 A100 上的吞吐量和首个令牌延迟。H100 FP8,A100 FP16,SXM 80GB GPU,提供 ISL/OSL,TP=1,BS=32/64 最大吞吐量,BS=1 首个令牌延迟。TensorRT-LLM v0.5.0,TensorRT 9.1。 通过扫描 BS 1,2,…,64 计算最大吞吐量。吞吐量取自最大成功值。

最大吞吐量与最小延迟

模型 |

批量大小 |

输入长度 |

输出长度 |

吞吐量(输出 tok/s) |

第一个令牌延迟(毫秒) |

|---|---|---|---|---|---|

H100 |

|||||

GPT-J 6B |

64 |

128 |

128 |

10,907 |

102 |

GPT-J 6B |

1 |

128 |

- |

185 |

7.1 |

A100 |

|||||

GPT-J 6B |

64 |

128 |

128 |

3,679 |

481 |

GPT-J 6B |

1 |

128 |

- |

111 |

12.5 |

加速 |

|||||

GPT-J 6B |

64 |

128 |

128 |

3.0倍 |

4.7x |

GPT-J 6B |

1 |

128 |

- |

2.4倍 |

1.7倍 |

FP8 H100, FP16 A100, SXM 80GB GPUs, TP1, ISL/OSL’s 提供, TensorRT-LLM v0.5.0., TensorRT 9.1

这些图表和表格背后的完整数据,包括具有更高TP值的更大模型,可以在TensorRT-LLM的性能文档中找到。

敬请期待即将推出的Llama亮点!

在H100上使用FP8的MLPerf

在最近的MLPerf结果中,NVIDIA展示了在NVIDIA H100上的模型推理性能比之前在NVIDIA A100 Tensor Core GPU上的结果快了最多4.5倍。使用相同的数据类型,H100比A100快了2倍。切换到FP8后,速度又提高了2倍。

什么是H100 FP8?

H100是NVIDIA的下一代、性能最高的数据中心GPU。基于NVIDIA Hopper GPU架构,H100加速了云数据中心、服务器、边缘系统和工作站中的AI训练和推理、高性能计算(HPC)以及数据分析应用。H100提供对FP8数据类型的原生支持,与H100上的16位浮点选项相比,可以将性能提高一倍,并将内存消耗减半。

论文FP8 Formats for Deep Learning中引入的FP8规范可用于加速训练以及使用16位格式训练的模型的后训练量化进行推理。该规范包括两种编码 - E4M3(4位指数和3位尾数)和E5M2(5位指数和2位尾数)。推荐的FP8编码使用方式是E4M3用于权重和激活张量,E5M2用于梯度张量。

在实践中,FP8可以将H100(FP8与FP16相比)的感知性能提高超过2倍。FP8是一种W8A8格式,意味着权重和激活值或计算都以8位存储。8位权重减少了GPU内存消耗和带宽,这意味着可以在相同的GPU中容纳更大的模型、序列长度或批量大小。这可以启用新的用例,更大的最大批量大小可以将最大吞吐量提高到FP16 H100的2倍以上。