cuSPARSE

cuSPARSE(CUDA稀疏矩阵库)的API参考指南。

1. 简介

cuSPARSE库包含一组GPU加速的基础线性代数子程序,用于处理稀疏矩阵,其性能显著优于仅使用CPU的替代方案。根据具体操作的不同,该库针对稀疏度在70%至99.9%范围内的矩阵进行了优化。 该库基于NVIDIA® CUDA™运行时(属于CUDA工具包的一部分)实现,并设计为可通过C和C++调用。

另请参阅 cuSPARSELt: 用于稀疏矩阵乘法的高性能CUDA库

cuSPARSE 版本说明: cuda-toolkit-release-notes

cuSPARSE GitHub示例: CUDALibrarySamples

Nvidia开发者论坛: GPU加速库

提供反馈: Math-Libs-Feedback@nvidia.com

近期cuSPARSE/cuSPARSELt博客文章与GTC演讲:

该库例程提供以下功能:

稀疏向量与稠密向量之间的操作:求和、点积、分散、聚集

稠密矩阵与稀疏向量之间的运算:乘法

稀疏矩阵与稠密向量之间的运算:乘法、三角求解器、三对角求解器、五对角求解器

稀疏矩阵与稠密矩阵之间的运算:乘法、三角求解器、三对角求解器、五对角求解器

稀疏矩阵与稀疏矩阵之间的运算:求和、乘法

稠密矩阵之间的运算,输出结果为稀疏矩阵:乘法

稀疏矩阵预处理器: 不完全Cholesky分解(级别0), 不完全LU分解(级别0)

在不同稀疏矩阵存储格式之间进行重新排序和转换操作

1.1. 库组织结构与特性

cuSPARSE库分为两组API:

传统API受到稀疏BLAS标准的启发,提供了一套有限的功能集,并且在未来的版本中不会进行改进,尽管仍会确保标准维护。这一类别中的某些例程可能会在短期内被弃用并移除。在弃用过程中,将为其中最重要的功能提供替代方案。

-

通用API提供了cuSPARSE的标准接口层。它们允许以灵活的方式计算最常见的稀疏线性代数运算,例如稀疏矩阵-向量乘法(SpMV)和稀疏矩阵-矩阵乘法(SpMM)。新API具有以下功能和特点:

设置矩阵数据的布局、批次数量和存储格式(例如CSR、COO等)。

设置输入/输出/计算数据类型。这也支持混合数据类型计算。

设置稀疏向量/矩阵索引的类型(例如32位、64位)。

选择用于计算的算法。

为内部操作确保外部设备内存。

提供对输入矩阵和向量的全面一致性检查。这包括验证大小、数据类型、布局、允许的操作等。

为向量和矩阵输入提供常量描述符,以支持常量安全接口,并确保API不会修改其输入。

1.2. 静态库支持

从CUDA 6.5开始,cuSPARSE库在Linux平台上还以静态形式提供,文件名为libcusparse_static.a。

例如,要使用cuSPARSE针对动态库编译一个小型应用程序,可以使用以下命令:

nvcc my_cusparse_app.cu -lcusparse -o my_cusparse_app

而要针对静态库进行编译,则必须使用以下命令:

nvcc my_cusparse_app.cu -lcusparse_static -o my_cusparse_app

也可以使用原生Host C++编译器。根据主机操作系统的不同,在链接行可能需要一些额外的库,如pthread或dl。在Linux上建议使用以下命令:

gcc my_cusparse_app.c -lcusparse_static -lcudart_static -lpthread -ldl -I <cuda-toolkit-path>/include -L <cuda-toolkit-path>/lib64 -o my_cusparse_app

请注意,在后一种情况下,不需要cuda库。CUDA运行时会根据需要尝试显式打开cuda库。对于未安装CUDA驱动的系统,这允许应用程序优雅地处理此问题,并在仅支持CPU路径的情况下仍可能运行。

1.3. 库依赖项

从CUDA 12.0开始,cuSPARSE将依赖nvJitLink库来实现JIT(即时)LTO(链接时优化)功能;更多信息请参阅cusparseSpMMOp() API。

如果用户链接到动态库,运行时加载库的环境变量(例如Linux上的LD_LIBRARY_PATH和Windows上的PATH)必须包含libnvjitlink.so所在的路径。如果它与cuSPARSE位于同一目录,则用户无需采取任何操作。

如果链接到静态库,用户需要链接-lnvjitlink并相应设置编译时加载库的环境变量LIBRARY_PATH/PATH。

2. 使用cuSPARSE API

本章介绍如何使用cuSPARSE库API。它并非cuSPARSE API数据类型和函数的参考文档,这些内容将在后续章节中提供。

2.1. API使用说明

cuSPARSE库使开发者能够访问NVIDIA图形处理单元(GPU)的计算资源。

cuSPARSE API 假设输入和输出数据(向量和矩阵)驻留在 GPU(设备)内存中。

输入和输出的标量(例如\(\alpha\)和\(\beta\))可以通过主机或设备上的引用传递,而不仅限于在主机上通过值传递。这使得库函数即使由先前内核生成也能使用流异步执行,从而实现最大并行度。

通过函数初始化cuSPARSE库上下文的句柄,并显式传递给后续所有库函数调用。这使得用户在使用多主机线程和多GPU时能更好地控制库的设置。

所有cuSPARSE库函数调用都会返回错误状态

cusparseStatus_t。

开发者的职责是使用标准CUDA运行时API例程(如cudaMalloc()、cudaFree()、cudaMemcpy()和cudaMemcpyAsync())分配内存并在GPU内存与CPU内存之间复制数据。

cuSPARSE库函数相对于主机是异步执行的,可能在结果准备好之前就将控制权返回给主机应用程序。开发人员可以使用cudaDeviceSynchronize()函数来确保特定cuSPARSE库例程的执行已完成。

开发者也可以使用cudaMemcpy()例程,通过分别指定cudaMemcpyDeviceToHost和cudaMemcpyHostToDevice参数,将数据从设备复制到主机或反之。在这种情况下,无需额外调用cudaDeviceSynchronize(),因为使用上述参数的cudaMemcpy()调用是阻塞式的,只有当结果在主机端准备就绪时才会完成。

2.2. 已弃用的API

cuSPARSE库文档明确标注了已弃用的API/枚举器/数据结构集合。对于已弃用的API,该库遵循以下策略:

-

API在X.Y版本(例如11.2)上被标记为

[[DEPRECATED]]如果有可用的替代方案,文档会进行索引

否则,该功能在未来将不会被维护

该API将在X+1.0版本(例如12.0)中被移除

即使对于已弃用的API,仍会修复正确性错误,但性能问题并不总能得到保证。

除了文档说明外,当使用已弃用的API时,在大多数平台上会生成编译时警告。可以通过在包含cusparse.h之前定义宏DISABLE_CUSPARSE_DEPRECATED,或者向编译器传递标志-DDISABLE_CUSPARSE_DEPRECATED来禁用弃用警告。

2.3. 线程安全

该库是线程安全的。

只要它所使用的数据没有同时被其他线程写入,就可以在任何线程中随时安全地调用任何函数。

cuSPARSE函数是否写入对象通常通过const参数来指示。

不建议在多个线程之间共享同一个cuSPARSE句柄。 虽然可以这样做,但对句柄的更改 (例如设置流或销毁) 会影响所有线程并引发全局同步问题。

2.4. 结果可复现性

cuSPARSE的设计优先考虑性能而非逐位可重现性。

使用转置或共轭转置的操作 cusparseOperation_t 无法保证可重现性。

对于剩余的操作, 在同一台机器上使用相同的可执行文件,以完全相同的参数执行两次相同的API调用, 将产生位级完全相同的结果。 这种位级可重现性可能会受到以下变化的影响: 硬件、CUDA驱动程序、cuSPARSE版本、数据的内存对齐方式或算法选择。

2.5. NaN与Inf传播

浮点数有特殊的NaN(非数字)和Inf(无穷大)值。cuSPARSE中的函数不保证NaN和Inf的传播行为。

cuSPARSE算法在评估时假设所有浮点数值均为有限值。只有当算法恰好生成或传播NaN和Inf时,它们才会出现在输出结果中。由于算法可能根据工具包版本和运行时考量进行调整,因此NaN和Inf的传播行为也可能随之变化。

NaN传播在cuSPARSE中与典型的密集数值线性代数(如cuBLAS)有所不同。

向量[0, 1, 0]和[1, 1, NaN]的点积

在使用典型密集数值算法时为NaN,

但在典型稀疏数值算法中会是1.0。

2.6. 使用流实现并行计算

如果应用程序执行多个小型独立计算,或者在计算过程中并行传输数据,可以使用CUDA流来重叠这些任务。

The application can conceptually associate a stream with each task. To achieve the overlap of computation between the tasks, the developer should create CUDA streams using the function cudaStreamCreate() and set the stream to be used by each individual cuSPARSE library routine by calling cusparseSetStream() just before calling the actual cuSPARSE routine. Then, computations performed in separate streams would be overlapped automatically on the GPU, when possible. This approach is especially useful when the computation performed by a single task is relatively small and is not enough to fill the GPU with work, or when there is a data transfer that can be performed in parallel with the computation.

当使用流时,我们建议采用新的cuSPARSE API,通过设备内存中的引用传递标量参数和结果,以实现最大的计算重叠。

虽然开发者可以创建多个流,但实际上同时执行的并发内核数量不可能超过16个。

2.7. 兼容性与版本控制

cuSPARSE API旨在保持与未来版本的源代码级向后兼容性(除非特定未来版本的发布说明中另有说明)。换句话说,如果程序使用了cuSPARSE,它应该能在不修改源代码的情况下继续编译并正确运行于新版本的cuSPARSE。但cuSPARSE不保证二进制级别的向后兼容性。不支持混用不同版本的cusparse.h头文件和共享库。也不支持混用不同版本的cuSPARSE和CUDA运行时。

该库采用标准的版本语义约定来标识不同发布版本。

版本号由四个字段组成,以点号连接:MAJOR.MINOR.PATCH.BUILD

这些版本字段根据以下规则递增:

MAJOR: API重大变更或新CUDA主版本(底层破坏性变更,如驱动程序、编译器、库等)MINOR: 新增API和功能PATCH: 错误修复或性能改进(或 * 新CUDA版本)BUILD: 内部构建编号

* 不同版本的CUDA工具包会确保库版本号不同,即使库本身没有发生变化。

2.8. 优化说明

大多数cuSPARSE例程可以通过利用CUDA Graphs捕获和硬件内存压缩特性进行优化。

更详细地说,单个cuSPARSE调用或一系列调用可以被CUDA Graph捕获并在稍后执行。这最大限度地减少了内核启动开销,并允许CUDA运行时优化整个工作流程。关于将CUDA图捕获应用于cuSPARSE例程的完整示例,请参阅cuSPARSE Library Samples - CUDA Graph。

其次,cuSPARSE涉及的数据类型和功能适用于安培架构GPU设备(计算能力8.0及以上)提供的硬件内存压缩技术。该特性允许对含有足够多零字节的数据进行无损内存压缩。设备内存必须通过CUDA驱动API进行分配。关于硬件内存压缩在cuSPARSE例程中的应用完整示例,可参阅cuSPARSE库示例 - 内存压缩。

3. cuSPARSE存储格式

cuSPARSE库支持稠密和稀疏向量,以及稠密和稀疏矩阵格式。

3.1. 索引基础

该库支持从0开始和从1开始的索引方式,分别确保与C/C++和Fortran语言的兼容性。索引基准通过cusparseIndexBase_t类型进行选择。

3.2. 向量格式

本节介绍密集和稀疏向量格式。

3.2.1. 稠密向量格式

稠密向量通过存储在内存中的单个线性数据数组表示,例如下面的\(7 \times 1\)稠密向量。

密集向量表示

3.2.2. 稀疏向量格式

稀疏向量用两个数组表示。

values数组存储了密集格式等效数组中的非零值。

indices数组表示对应的非零值在密集格式等效数组中的位置。

例如,3.2.1节中的密集向量可以存储为使用从零开始或从一开始索引的稀疏向量。

稀疏向量表示

注意

cuSPARSE例程假设索引是按递增顺序提供的,并且每个索引仅出现一次。在相反的情况下,计算的正确性并不总是能得到保证。

3.3. 矩阵格式

本节将讨论矩阵的密集格式和几种稀疏格式。

3.3.1. 稠密矩阵格式

密集矩阵可以存储在行优先和列优先的内存布局(排序)中,它由以下参数表示。

矩阵中的行数。

矩阵中的列数。

-

主维度必须满足

大于或等于行优先布局中的列数

大于或等于列优先布局中的行数

-

指向长度为值数组的指针

\(rows \times leading\; dimension\) 在行优先布局中

\(columns \times leading\; dimension\) 在列优先布局中

下图展示了一个\(5 \times 2\)密集矩阵的两种内存布局方式

稠密矩阵表示

矩阵中的索引表示内存中的连续位置。

前导维度有助于表示原始矩阵中的一个子矩阵

子矩阵表示

3.3.2. 坐标格式 (COO)

以COO格式存储的稀疏矩阵由以下参数表示。

矩阵中的行数。

矩阵中的列数。

矩阵中的非零元素数量 (

nnz)。指向长度为

nnz的行索引数组的指针,该数组包含值数组中对应元素的行索引。指向长度为

nnz的列索引数组的指针,该数组包含值数组中对应元素的列索引。指向长度为

nnz的值数组的指针,该数组以行优先顺序存储矩阵的所有非零值。COO表示法中的每个条目由一个

<行, 列>对组成。COO格式假定为按行排序。

以下示例展示了一个以COO格式表示的\(5 \times 4\)矩阵。

注意

cuSPARSE支持给定行内已排序和未排序的列索引。

注意

如果给定行中的列索引不唯一,则无法始终保证计算的正确性。

给定一个COO格式(基于零)的条目,对应的密集矩阵位置计算如下:

// row-major

rows_indices[i] * leading_dimension + column_indices[i]

// column-major

column_indices[i] * leading_dimension + rows_indices[i]

3.3.3. 压缩稀疏行(CSR)

CSR格式与COO类似,其中行索引被压缩并替换为一个偏移量数组。

以CSR格式存储的稀疏矩阵由以下参数表示。

矩阵中的行数。

矩阵中的列数。

矩阵中的非零元素数量 (

nnz)。指向长度为行数 + 1的行偏移量数组的指针,该数组表示每行在列和值数组中的起始位置。

指向长度为

nnz的列索引数组的指针,该数组包含值数组中对应元素的列索引。指向长度为

nnz的值数组的指针,该数组以行优先顺序存储矩阵的所有非零值。

以下示例展示了一个以CSR格式表示的\(5 \times 4\)矩阵。

注意

cuSPARSE支持给定行内已排序和未排序的列索引。

注意

如果给定行中的列索引不唯一,则无法始终保证计算的正确性。

给定CSR格式(基于零)中的一个条目,其在稠密矩阵中的对应位置计算如下:

// row-major

row * leading_dimension + column_indices[row_offsets[row] + k]

// column-major

column_indices[row_offsets[row] + k] * leading_dimension + row

3.3.4. 压缩稀疏列(CSC)

CSC格式与COO类似,其中列索引被压缩并替换为一个偏移量数组。

以CSC格式存储的稀疏矩阵由以下参数表示。

矩阵中的行数。

矩阵中的列数。

矩阵中的非零元素数量 (

nnz)。指向长度为列数 + 1的列偏移量数组的指针,该数组表示每列在列和值数组中的起始位置。

指向长度为

nnz的行索引数组的指针,该数组包含值数组中对应元素的行索引。指向长度为

nnz的values数组的指针,该数组以列主序存储矩阵的所有非零值。

以下示例展示了一个以CSC格式表示的\(5 \times 4\)矩阵。

注意

CSR格式的内存布局与其在CSC格式中的转置完全相同(反之亦然)。

注意

cuSPARSE支持在给定列内使用已排序和未排序的行索引。

注意

如果给定列中的行索引不唯一,则无法始终保证计算的正确性。

给定CSC格式(基于零索引)中的一个条目,其在稠密矩阵中的对应位置计算如下:

// row-major

column * leading_dimension + row_indices[column_offsets[column] + k]

// column-major

row_indices[column_offsets[column] + k] * leading_dimension + column

3.3.5. 切片式Ellpack (SELL)

Sliced Ellpack格式是一种标准化且广为人知的先进技术。该格式能显著提升所有涉及每行非零元素数量变化较小问题的性能。

在Sliced Ellpack格式中,矩阵被划分为由用户定义的精确行数(\(sliceSize\))组成的切片。

每个切片会计算其最大行长度(即每行非零元素的最大数量),并将切片中的每一行填充至该最大长度。

填充时使用值-1。

一个\(m \times n\)的稀疏矩阵\(A\)等价于一个具有\(nslices = \left \lceil{\frac{m}{sliceSize}}\right \rceil\)切片行和\(n\)列的切片稀疏矩阵\(A_{s}\)。为了提高内存合并和内存利用率,每个切片以列优先顺序存储。

以SELL格式存储的稀疏矩阵由以下参数表示。

切片数量。

矩阵中的行数。

矩阵中的列数。

矩阵中的非零元素数量 (

nnz)。元素总数 (

sellValuesSize),包括非零值和填充元素。指向长度为\(nslices + 1\)的切片偏移量的指针,该偏移量保存与列和值数组对应的切片的偏移量。

指向长度为

sellValuesSize的列索引数组的指针,该数组包含values数组中对应元素的列索引。列索引以列优先方式存储。值-1表示填充。指向长度为

sellValuesSize的values数组的指针,该数组以列优先布局保存所有非零值和填充。

以下示例展示了一个以SELL格式表示的\(5 \times 4\)矩阵。

3.3.6. 块稀疏行(BSR)

BSR格式与CSR类似,其中列索引表示的是二维块而非单个矩阵元素。

Block Sparse Row格式的矩阵被组织成由用户定义的大小为\(blockSize\)的块。

一个\(m \times n\)的稀疏矩阵\(A\)等价于一个块稀疏矩阵\(A_{B}\):\(mb \times nb\),其中\(mb = \frac{m}{blockSize}\)个块行和\(nb = \frac{n}{blockSize}\)个块列。 如果\(m\)或\(n\)不是\(blockSize\)的倍数,用户需要用零填充矩阵。

注意

cuSPARSE目前仅支持方形块。

BSR格式以行优先顺序存储块。然而,块的内部存储格式可以是列优先(cusparseDirection_t=CUSPARSE_DIRECTION_COLUMN)或行优先(cusparseDirection_t=CUSPARSE_DIRECTION_ROW),与基索引无关。

以BSR格式存储的稀疏矩阵由以下参数表示。

块大小。

矩阵中的行块数量。

矩阵中的列块数量。

矩阵中的非零块数量 (

nnzb)。指向长度为行块数 + 1的行块偏移数组的指针,该数组表示每个行块在列和值数组中的起始位置。

指向长度为

nnzb的列块索引数组的指针,该数组包含值数组中对应元素的位置。指向长度为

nnzb的值数组的指针,该数组保存矩阵的所有非零值。

以下示例展示了一个以BSR格式表示的\(4 \times 7\)矩阵。

3.3.7. 分块Ellpack格式(BLOCKED-ELL)

Blocked Ellpack格式与标准Ellpack类似,其中列索引表示的是二维块而非单个矩阵条目。

Blocked Ellpack格式的矩阵被组织成由用户定义的大小为\(blockSize\)的块。每行的列数\(nEllCols\)也由用户定义(\(nEllCols \le n\))。

一个\(m \times n\)的稀疏矩阵\(A\)等价于一个分块ELL矩阵\(A_{B}\):具有\(mb = \left \lceil{\frac{m}{blockSize}}\right \rceil\)个块行和\(nb = \left \lceil{\frac{nEllCols}{blockSize}}\right \rceil\)个块列的\(mb \times nb\)矩阵。 如果\(m\)或\(n\)不是\(blockSize\)的倍数,则剩余元素为零。

以Blocked-ELL格式存储的稀疏矩阵由以下参数表示。

块大小。

矩阵中的行数。

矩阵中的列数。

矩阵中每行的列数 (

nEllCols)。指向长度为\(mb \times nb\)的列块索引数组的指针,该数组包含值数组中对应元素的位置。空块可以用

-1索引表示。指向长度为\(m \times nEllCols\)的值数组的指针,该数组以行优先顺序存储矩阵的所有非零值。

以下示例展示了一个以Blocked-ELL格式表示的\(9 \times 9\)矩阵。

3.3.8. 扩展BSR格式(BSRX) [已弃用]

BSRX格式与BSR格式类似,但数组bsrRowPtrA被分为两部分。每行的第一个非零块仍由数组bsrRowPtrA指定(与BSR格式相同),但每行最后一个非零块的下一个位置由数组bsrEndPtrA指定。简而言之,BSRX格式就像是BSR格式的四向量变体。

矩阵 A 通过以下参数以BSRX格式表示。

|

(整数) |

矩阵 |

|

(整数) |

|

|

(整数) |

|

|

(整数) |

矩阵 |

|

(指针) |

指向长度为\(nnzb \ast blockDim^{2}\)的数据数组,该数组保存了 |

|

(指针) |

指向长度为 |

|

(指针) |

指向长度为 |

|

(指针) |

指向长度为 |

BSR和BSRX之间的简单转换可以按如下方式进行。假设开发者有一个\(2 \times 3\)块稀疏矩阵\(A_{b}\),其表示形式如下所示。

假设它具有以下BSR格式:

BSRX格式中的bsrRowPtrA就是BSR格式bsrRowPtrA的前两个元素。而BSRX格式的bsrEndPtrA则是BSR格式bsrRowPtrA的最后两个元素。

BSRX格式的优势在于,开发者可以通过修改bsrRowPtrA和bsrEndPtrA来指定原始BSR格式中的子矩阵,同时保持bsrColIndA和bsrValA不变。

例如,要创建一个与\(A\)略有不同的块矩阵\(\widetilde{A} = \begin{bmatrix}

O & O & O \\

O & A_{11} & O \\

\end{bmatrix}\),开发者可以保留bsrColIndA和bsrValA,但通过正确设置bsrRowPtrA和bsrEndPtrA来重构\(\widetilde{A}\)。以下4维向量描述了\(\widetilde{A}\)。

4. cuSPARSE基础API

4.1. cuSPARSE 类型参考

4.1.1. cuda数据类型_t

本节描述了多个CUDA库共享的类型,这些类型定义在头文件library_types.h中。cudaDataType类型是一个枚举器,用于指定数据精度。当数据引用本身不携带类型时(例如void*)会使用它。例如,该类型在例程cusparseSpMM()中被使用。

值 |

含义 |

数据类型 |

头信息 |

|

|---|---|---|---|---|

|

数据类型为16位IEEE-754浮点数 |

|

cuda_fp16.h |

|

|

数据类型为16位复数IEEE-754浮点数 |

|

cuda_fp16.h |

[已弃用] |

|

数据类型为16位bfloat浮点数 |

|

cuda_bf16.h |

|

|

数据类型为16位复数bfloat浮点数 |

|

cuda_bf16.h |

[已弃用] |

|

数据类型为32位IEEE-754浮点数 |

|

||

|

数据类型为32位复数IEEE-754浮点数 |

|

cuComplex.h |

|

|

该数据类型为64位IEEE-754浮点数 |

|

||

|

数据类型为64位复数IEEE-754浮点数 |

|

cuComplex.h |

|

|

数据类型为8位整数 |

|

stdint.h |

|

|

数据类型为32位整数 |

|

stdint.h |

重要提示:通用API例程仅支持在具有原生支持的GPU架构上使用文档相应章节中列出的所有数据类型。如果特定GPU型号未提供对给定数据类型的原生支持,该例程将返回CUSPARSE_STATUS_ARCH_MISMATCH错误。

不支持的数据类型和计算能力(CC):

__half在计算能力CC < 53的GPU上(例如Kepler架构)__nv_bfloat16在计算能力CC < 80的GPU上(例如Kepler、Maxwell、Pascal、Volta、Turing架构)

参见 https://developer.nvidia.com/cuda-gpus

4.1.2. cusparseStatus_t

该数据类型表示库函数返回的状态,它可以有以下取值:

值 |

描述 |

|---|---|

|

操作成功完成 |

|

cuSPARSE库未被初始化。这通常是由于缺少先前的调用、cuSPARSE例程调用的CUDA Runtime API出错,或硬件设置错误导致的 需要修正:在调用该函数前先调用 该错误同样适用于通用API(cuSPARSE通用API),用于表示矩阵/向量描述符未初始化 |

|

cuSPARSE库内部资源分配失败。这通常由设备内存分配( 需要修正:在函数调用前,尽可能释放之前分配的内存 |

|

向函数传递了不支持的值或参数(例如负向量大小) 需要修正:确保所有传递的参数都具有有效值 |

|

该函数需要的功能在当前设备架构中缺失 需要修正:在具有适当计算能力的设备上编译并运行应用程序 |

|

GPU程序执行失败。这通常是由于GPU上的内核启动失败引起的,可能由多种原因导致 需要修正: 检查硬件、适当版本的驱动程序以及cuSPARSE库是否正确安装 |

|

内部cuSPARSE操作失败 需要修正: 检查硬件设备、适当版本的驱动程序以及cuSPARSE库是否正确安装。同时,确保作为参数传递给例程的内存在例程完成前未被释放。 |

|

该函数不支持此矩阵类型。这通常是由于向函数传递了无效的矩阵描述符所致 需要修正: 检查 |

|

该函数目前不支持此操作或数据类型组合 |

|

The resources for the computation, such as GPU global or shared memory, are not sufficient to complete the operation. The error can also indicate that the current computation mode (e.g. bit size of sparse matrix indices) does not allow to handle the given input |

4.1.3. cusparseHandle_t

这是一个指向不透明cuSPARSE上下文的指针类型,用户必须在调用任何其他库函数之前通过调用cusparseCreate()来初始化它。由cusparseCreate()创建并返回的句柄必须传递给每个cuSPARSE函数。

4.1.4. cusparsePointerMode_t

该类型用于指示标量值是通过主机还是设备引用传递。需要特别指出的是,如果在函数调用中通过引用传递多个标量值,它们都将遵循相同的单一指针模式。指针模式可以分别通过cusparseSetPointerMode()和cusparseGetPointerMode()例程进行设置和获取。

值 |

含义 |

|---|---|

|

标量通过主机上的引用传递。 |

|

标量通过设备上的引用传递。 |

4.1.5. cusparseOperation_t

此类型指示对相关输入(例如稀疏矩阵或向量)应用了哪些操作。

值 |

含义 |

|---|---|

|

选择非转置操作。 |

|

已选择转置操作。 |

|

选择了共轭转置操作。 |

4.1.6. cusparseDiagType_t

此类型表示矩阵对角线元素是否为1。对角线元素始终被视为存在,但如果将CUSPARSE_DIAG_TYPE_UNIT传递给API例程,则该例程会假定所有对角线元素均为1,且不会读取或修改这些元素。请注意,在这种情况下,无论内存中实际设置的值是多少,例程都会假定对角线元素等于1。

值 |

含义 |

|---|---|

|

矩阵对角线包含非单位元素。 |

|

矩阵对角线上的元素为单位元素。 |

4.1.7. cusparseFillMode_t

该类型指示矩阵的下三角部分还是上三角部分存储在稀疏存储中。

值 |

含义 |

|---|---|

|

存储的是下三角部分。 |

|

存储的是矩阵的上三角部分。 |

4.1.8. cusparseIndexBase_t

该类型表示矩阵索引的基数是零还是一。

值 |

含义 |

|---|---|

|

基础索引从零开始(兼容C语言)。 |

|

基础索引从1开始(与Fortran兼容)。 |

4.1.9. cusparseDirection_t

该类型指示在函数cusparse[S|D|C|Z]nnz中,稠密矩阵的元素应按行还是按列进行解析(假设内存中稠密矩阵采用列优先存储)。此外,BSR格式中块的存储格式也由此类型控制。

值 |

含义 |

|---|---|

|

矩阵应按行解析。 |

|

矩阵应按列解析。 |

4.2. cuSPARSE管理API

本节介绍用于管理库的cuSPARSE函数。

4.2.1. cusparseCreate()

cusparseStatus_t

cusparseCreate(cusparseHandle_t *handle)

该函数用于初始化cuSPARSE库并创建cuSPARSE上下文句柄。在调用任何其他cuSPARSE API函数之前,必须先调用此函数。它会分配访问GPU所需的硬件资源。

参数 |

输入/输出 |

含义 |

|---|---|---|

|

IN |

指向cuSPARSE上下文句柄的指针 |

有关返回状态的描述,请参考cusparseStatus_t。

4.2.2. cusparseDestroy()

cusparseStatus_t

cusparseDestroy(cusparseHandle_t handle)

此函数释放cuSPARSE库使用的CPU端资源。GPU端资源的释放可能会延迟到应用程序关闭时。

参数 |

输入/输出 |

含义 |

|---|---|---|

|

IN |

cuSPARSE上下文的句柄 |

有关返回状态的描述,请参考cusparseStatus_t。

4.2.3. cusparseGetErrorName()

const char*

cusparseGetErrorString(cusparseStatus_t status)

该函数返回错误代码枚举名称的字符串表示形式。如果错误代码未被识别,则返回“无法识别的错误代码”。

参数 |

输入/输出 |

含义 |

|---|---|---|

|

IN |

将错误代码转换为字符串 |

|

输出 |

指向以NULL结尾的字符串的指针 |

4.2.4. cusparseGetErrorString()

const char*

cusparseGetErrorString(cusparseStatus_t status)

返回错误码的描述字符串。如果错误码未被识别,则返回“无法识别的错误码”。

参数 |

输入/输出 |

含义 |

|---|---|---|

|

IN |

将错误代码转换为字符串 |

|

输出 |

指向以NULL结尾的字符串的指针 |

4.2.5. cusparseGetProperty()

cusparseStatus_t

cusparseGetProperty(libraryPropertyType type,

int* value)

该函数返回所请求属性的值。支持的属性类型请参考libraryPropertyType。

参数 |

输入/输出 |

含义 |

|---|---|---|

|

IN |

请求的属性 |

|

输出 |

请求属性的值 |

libraryPropertyType (定义于 library_types.h):

值 |

含义 |

|---|---|

|

用于查询主版本的枚举器 |

|

用于查询次要版本的枚举器 |

|

用于标识补丁级别的编号 |

有关返回状态的描述,请参考cusparseStatus_t。

4.2.6. cusparseGetVersion()

cusparseStatus_t

cusparseGetVersion(cusparseHandle_t handle,

int* version)

该函数返回cuSPARSE库的版本号。

参数 |

输入/输出 |

含义 |

|---|---|---|

|

IN |

cuSPARSE 句柄 |

|

输出 |

库的版本号 |

有关返回状态的描述,请参考cusparseStatus_t。

4.2.7. cusparseGetPointerMode()

cusparseStatus_t

cusparseGetPointerMode(cusparseHandlet handle,

cusparsePointerMode_t *mode)

该函数获取cuSPARSE库使用的指针模式。详情请参阅关于cusparsePointerMode_t类型的章节。

参数 |

输入/输出 |

含义 |

|---|---|---|

|

IN |

cuSPARSE上下文的句柄 |

|

输出 |

枚举指针模式类型之一 |

有关返回状态的描述,请参考cusparseStatus_t。

4.2.8. cusparseSetPointerMode()

cusparseStatus_t

cusparseSetPointerMode(cusparseHandle_t handle,

cusparsePointerMode_t mode)

此函数设置cuSPARSE库使用的指针模式。默认情况下,值通过主机上的引用传递。有关更多详细信息,请参阅cublasPointerMode_t类型的相关章节。

参数 |

输入/输出 |

含义 |

|---|---|---|

|

IN |

cuSPARSE上下文的句柄 |

|

IN |

枚举指针模式类型之一 |

有关返回状态的描述,请参考cusparseStatus_t。

4.2.9. cusparseGetStream()

cusparseStatus_t

cusparseGetStream(cusparseHandle_t handle, cudaStream_t *streamId)

此函数获取当前用于执行所有cuSPARSE库函数调用的cuSPARSE库流。如果未设置cuSPARSE库流,则所有内核将使用默认的NULL流。

参数 |

输入/输出 |

含义 |

|---|---|---|

|

IN |

cuSPARSE上下文的句柄 |

|

输出 |

该库使用的流 |

有关返回状态的描述,请参考cusparseStatus_t。

4.2.10. cusparseSetStream()

cusparseStatus_t

cusparseSetStream(cusparseHandle_t handle, cudaStream_t streamId)

此函数设置cuSPARSE库用于执行其例程的流。

参数 |

输入/输出 |

含义 |

|---|---|---|

|

IN |

cuSPARSE上下文的句柄 |

|

IN |

库将使用的流 |

有关返回状态的描述,请参考cusparseStatus_t。

4.3. cuSPARSE日志记录API

可以通过在启动目标应用程序之前设置以下环境变量来启用cuSPARSE日志记录机制:

CUSPARSE_LOG_LEVEL= - 其中level为以下级别之一:

0- 关闭 - 日志记录已禁用(默认)1- 错误 - 仅记录错误信息2- 追踪 - 调用启动CUDA内核的API会记录其参数和重要信息3- 提示 - 可能提升应用性能的提示4- 信息 - 提供关于库执行的一般信息,可能包含启发式算法状态的细节5- API跟踪 - API调用将记录其参数和重要信息

CUSPARSE_LOG_MASK= - 其中mask是以下掩码的组合:

0- 关闭1- 错误2- 追踪4- 提示8- 信息16- API 追踪

CUSPARSE_LOG_FILE= - 其中file_name是日志文件的路径。文件名可以包含%i,它将被替换为进程ID。例如

如果未定义CUSPARSE_LOG_FILE,日志消息将被打印到stdout。

从CUDA 12.3开始,还可以通过在创建过程中设置环境变量CUSPARSE_STORE_INPUT_MATRIX将稀疏矩阵(CSR、CSC、COO、SELL、BSR)转储到二进制文件中。之后,可以将这些二进制文件发送至Math-Libs-Feedback@nvidia.com,用于调试和复现特定正确性/性能问题。

另一个选项是使用实验性的cuSPARSE日志记录API。参考:

注意

旧版API不支持日志记录机制。

4.3.1. cusparseLoggerSetCallback()

cusparseStatus_t

cusparseLoggerSetCallback(cusparseLoggerCallback_t callback)

实验性功能:该函数用于设置日志记录回调函数。

参数 |

输入/输出 |

含义 |

|---|---|---|

|

IN |

指向回调函数的指针 |

其中 cusparseLoggerCallback_t 具有以下签名:

void (*cusparseLoggerCallback_t)(int logLevel,

const char* functionName,

const char* message)

参数 |

输入/输出 |

含义 |

|---|---|---|

|

IN |

选定的日志级别 |

|

IN |

记录此消息的API名称 |

|

IN |

日志消息 |

有关返回状态的描述,请参见cusparseStatus_t。

4.3.2. cusparseLoggerSetFile()

cusparseStatus_t

cusparseLoggerSetFile(FILE* file)

实验性功能: 此函数用于设置日志输出文件。注意:通过此函数调用注册后,除非再次调用该函数切换至其他文件句柄,否则不得关闭提供的文件句柄。

参数 |

输入/输出 |

含义 |

|---|---|---|

|

IN |

指向一个已打开文件的指针。该文件应具有写入权限 |

有关返回状态的描述,请参见cusparseStatus_t。

4.3.3. cusparseLoggerOpenFile()

cusparseStatus_t

cusparseLoggerOpenFile(const char* logFile)

实验性功能:该函数会在指定路径下打开一个日志输出文件。

参数 |

输入/输出 |

含义 |

|---|---|---|

|

IN |

日志输出文件的路径 |

有关返回状态的描述,请参见cusparseStatus_t。

4.3.4. cusparseLoggerSetLevel()

cusparseStatus_t

cusparseLoggerSetLevel(int level)

实验性功能: 该函数用于设置日志记录级别的值。路径。

参数 |

输入/输出 |

含义 |

|---|---|---|

|

IN |

日志记录级别的值 |

有关返回状态的描述,请参见cusparseStatus_t

4.3.5. cusparseLoggerSetMask()

cusparseStatus_t

cusparseLoggerSetMask(int mask)

实验性功能: 该函数用于设置日志掩码的值。

参数 |

输入/输出 |

含义 |

|---|---|---|

|

IN |

日志掩码的值 |

有关返回状态的描述,请参见cusparseStatus_t

5. cuSPARSE传统API

5.1. 命名规范

cuSPARSE传统函数支持以下数据类型:float、double、cuComplex和cuDoubleComplex。稀疏矩阵的Level 2和Level 3函数遵循以下命名规范:

cusparse<t>[<matrix data format>]<operation>[<output matrix data format>]

其中 <t> 可以是 S、D、C、Z 或 X,分别对应数据类型 float、double、cuComplex、cuDoubleComplex 以及通用类型。

matrix data format可以是dense、coo、csr或csc,分别对应稠密矩阵、坐标格式、压缩稀疏行格式和压缩稀疏列格式。

5.2. cuSPARSE传统类型参考

5.2.1. cusparseAction_t

该类型指示操作是仅针对索引执行,还是针对数据和索引执行。

值 |

含义 |

|---|---|

|

该操作仅在索引上执行。 |

|

该操作在数据和索引上执行。 |

5.2.2. cusparseMatDescr_t

此结构用于描述矩阵的形状和属性。

typedef struct {

cusparseMatrixType_t MatrixType;

cusparseFillMode_t FillMode;

cusparseDiagType_t DiagType;

cusparseIndexBase_t IndexBase;

} cusparseMatDescr_t;

5.2.3. cusparseMatrixType_t

此类型表示稀疏存储中矩阵的类型。请注意,对于对称矩阵、厄米特矩阵和三角矩阵,仅存储其下三角或上三角部分。

矩阵类型和填充模式的整体思路是保持对称/厄米特矩阵的最小存储量,同时利用SpMV(稀疏矩阵向量乘法)中的对称特性。当A是对称矩阵且仅存储下三角部分时,计算y=A*x需要两个步骤:第一步计算y=(L+D)*x,第二步计算y=L^T*x + y。考虑到转置操作y=L^T*x比非转置版本y=L*x慢10倍,对称特性并未带来任何性能优势。对于用户而言,更好的做法是将对称矩阵扩展为普通矩阵,并使用矩阵类型CUSPARSE_MATRIX_TYPE_GENERAL来执行y=A*x运算。

通常,在迭代求解器(如PCG和GMRES)中,SpMV、预处理器(不完全Cholesky或不完全LU)和三角求解器会结合使用。如果用户始终使用通用矩阵(而非对称矩阵),则预处理器无需支持通用矩阵以外的类型。因此,新例程[bsr|csr]sv2(三角求解器)、[bsr|csr]ilu02(不完全LU)和[bsr|csr]ic02(不完全Cholesky)仅支持矩阵类型CUSPARSE_MATRIX_TYPE_GENERAL。

值 |

含义 |

|---|---|

|

矩阵是通用的。 |

|

该矩阵是对称的。 |

|

该矩阵是厄米特矩阵。 |

|

该矩阵是三角矩阵。 |

5.2.4. cusparseColorInfo_t [已弃用]

这是一个指向不透明结构的指针类型,该结构保存了csrcolor()中使用的信息。

5.2.5. cusparseSolvePolicy_t [已弃用]

该类型指示是否在csrsv2, csric02, csrilu02, bsrsv2, bsric02 和 bsrilu02中生成和使用级别信息。

值 |

含义 |

|---|---|

|

未生成或使用任何层级信息。 |

|

生成并使用层级信息。 |

5.2.6. bsric02Info_t [已弃用]

这是一个指向不透明结构的指针类型,该结构保存了在bsric02_bufferSize()、bsric02_analysis()和bsric02()中使用的信息。

5.2.7. bsrilu02Info_t [已弃用]

这是一个指向不透明结构的指针类型,该结构保存了在bsrilu02_bufferSize()、bsrilu02_analysis()和bsrilu02()中使用的信息。

5.2.8. bsrsm2Info_t [已弃用]

这是一个指向不透明结构的指针类型,该结构保存了在bsrsm2_bufferSize()、bsrsm2_analysis()和bsrsm2_solve()中使用的信息。

5.2.9. bsrsv2Info_t [已弃用]

这是一个指向不透明结构的指针类型,该结构保存了在bsrsv2_bufferSize()、bsrsv2_analysis()和bsrsv2_solve()中使用的信息。

5.2.10. csric02Info_t [已弃用]

这是一个指向不透明结构的指针类型,该结构保存了在csric02_bufferSize()、csric02_analysis()和csric02()中使用的信息。

5.2.11. csrilu02Info_t [已弃用]

这是一个指向不透明结构的指针类型,该结构保存了在csrilu02_bufferSize()、csrilu02_analysis()和csrilu02()中使用的信息。

5.3. cuSPARSE辅助函数参考

本节介绍cuSPARSE辅助函数。

5.3.1. cusparseCreateColorInfo() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseCreateColorInfo(cusparseColorInfo_t* info)

该函数创建并初始化cusparseColorInfo_t结构体,将其设置为默认值。

输入

|

指向 |

有关返回状态的描述,请参见cusparseStatus_t。

5.3.2. cusparseCreateMatDescr()

cusparseStatus_t

cusparseCreateMatDescr(cusparseMatDescr_t *descrA)

该函数用于初始化矩阵描述符。它将字段MatrixType和IndexBase分别设置为默认值CUSPARSE_MATRIX_TYPE_GENERAL和CUSPARSE_INDEX_BASE_ZERO,而其他字段则保持未初始化状态。

输入

|

指向矩阵描述符的指针。 |

有关返回状态的描述,请参见cusparseStatus_t。

5.3.3. cusparseDestroyColorInfo() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseDestroyColorInfo(cusparseColorInfo_t info)

该函数销毁并释放该结构所需的任何内存。

输入

|

指向 |

有关返回状态的描述,请参见cusparseStatus_t。

5.3.4. cusparseDestroyMatDescr()

cusparseStatus_t

cusparseDestroyMatDescr(cusparseMatDescr_t descrA)

该函数释放为矩阵描述符分配的内存。

输入

|

矩阵描述符。 |

有关返回状态的描述,请参见cusparseStatus_t。

5.3.5. cusparseGetMatDiagType()

cusparseDiagType_t

cusparseGetMatDiagType(const cusparseMatDescr_t descrA)

该函数返回矩阵描述符descrA中的DiagType字段。

输入

|

矩阵描述符。 |

返回

|

枚举类型diagType中的一种。 |

5.3.6. cusparseGetMatFillMode()

cusparseFillMode_t

cusparseGetMatFillMode(const cusparseMatDescr_t descrA)

该函数返回矩阵描述符descrA的FillMode字段。

输入

|

矩阵描述符。 |

返回

|

枚举填充模式类型之一。 |

5.3.7. cusparseGetMatIndexBase()

cusparseIndexBase_t

cusparseGetMatIndexBase(const cusparseMatDescr_t descrA)

该函数返回矩阵描述符descrA的IndexBase字段。

输入

|

矩阵描述符。 |

返回

|

枚举的indexBase类型之一。 |

5.3.8. cusparseGetMatType()

cusparseMatrixType_t

cusparseGetMatType(const cusparseMatDescr_t descrA)

该函数返回矩阵描述符descrA的MatrixType字段。

输入

|

矩阵描述符。 |

返回

|

枚举矩阵类型之一。 |

5.3.9. cusparseSetMatDiagType()

cusparseStatus_t

cusparseSetMatDiagType(cusparseMatDescr_t descrA,

cusparseDiagType_t diagType)

此函数设置矩阵描述符descrA的DiagType字段。

输入

|

枚举的diagType类型之一。 |

输出

|

矩阵描述符。 |

有关返回状态的描述,请参见cusparseStatus_t。

5.3.10. cusparseSetMatFillMode()

cusparseStatus_t

cusparseSetMatFillMode(cusparseMatDescr_t descrA,

cusparseFillMode_t fillMode)

此函数设置矩阵描述符descrA的FillMode字段。

输入

|

枚举的fillMode类型之一。 |

输出

|

矩阵描述符。 |

有关返回状态的描述,请参见cusparseStatus_t。

5.3.11. cusparseSetMatIndexBase()

cusparseStatus_t

cusparseSetMatIndexBase(cusparseMatDescr_t descrA,

cusparseIndexBase_t base)

此函数设置矩阵描述符descrA的IndexBase字段。

输入

|

枚举的indexBase类型之一。 |

输出

|

矩阵描述符。 |

有关返回状态的描述,请参见cusparseStatus_t。

5.3.12. cusparseSetMatType()

cusparseStatus_t

cusparseSetMatType(cusparseMatDescr_t descrA, cusparseMatrixType_t type)

此函数设置矩阵描述符descrA的MatrixType字段。

输入

|

枚举矩阵类型之一。 |

输出

|

矩阵描述符。 |

有关返回状态的描述,请参见cusparseStatus_t。

5.3.13. cusparseCreateCsric02Info() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseCreateCsric02Info(csric02Info_t *info);

该函数创建并初始化不完全Cholesky的求解和分析结构为默认值。

输入

|

指向不完全Cholesky分解求解与分析结构的指针。 |

有关返回状态的描述,请参见cusparseStatus_t。

5.3.14. cusparseDestroyCsric02Info() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseDestroyCsric02Info(csric02Info_t info);

该函数销毁并释放该结构所需的任何内存。

输入

|

求解 |

有关返回状态的描述,请参见cusparseStatus_t。

5.3.15. cusparseCreateCsrilu02Info() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseCreateCsrilu02Info(csrilu02Info_t *info);

该函数创建并初始化不完全LU分解的求解和分析结构为默认值。

输入

|

指向不完全LU分解的求解与分析结构的指针。 |

有关返回状态的描述,请参见cusparseStatus_t。

5.3.16. cusparseDestroyCsrilu02Info() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseDestroyCsrilu02Info(csrilu02Info_t info);

该函数销毁并释放该结构所需的任何内存。

输入

|

求解 |

有关返回状态的描述,请参见cusparseStatus_t。

5.3.17. cusparseCreateBsrsv2Info() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseCreateBsrsv2Info(bsrsv2Info_t *info);

该函数创建并初始化bsrsv2的求解和分析结构为默认值。

输入

|

指向bsrsv2求解和分析结构的指针。 |

有关返回状态的描述,请参见cusparseStatus_t。

5.3.18. cusparseDestroyBsrsv2Info() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseDestroyBsrsv2Info(bsrsv2Info_t info);

该函数销毁并释放该结构所需的任何内存。

输入

|

解决 |

有关返回状态的描述,请参见cusparseStatus_t。

5.3.19. cusparseCreateBsrsm2Info() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseCreateBsrsm2Info(bsrsm2Info_t *info);

该函数创建并初始化bsrsm2的求解和分析结构为默认值。

输入

|

指向bsrsm2求解和分析结构的指针。 |

有关返回状态的描述,请参见cusparseStatus_t。

5.3.20. cusparseDestroyBsrsm2Info() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseDestroyBsrsm2Info(bsrsm2Info_t info);

该函数销毁并释放该结构所需的任何内存。

输入

|

解决 |

有关返回状态的描述,请参见cusparseStatus_t。

5.3.21. cusparseCreateBsric02Info() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseCreateBsric02Info(bsric02Info_t *info);

此函数创建并初始化块不完全Cholesky的求解和分析结构为默认值。

输入

|

指向块不完全Cholesky求解和分析结构的指针。 |

有关返回状态的描述,请参见cusparseStatus_t。

5.3.22. cusparseDestroyBsric02Info() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseDestroyBsric02Info(bsric02Info_t info);

该函数销毁并释放该结构所需的任何内存。

输入

|

求解 |

有关返回状态的描述,请参见cusparseStatus_t。

5.3.23. cusparseCreateBsrilu02Info() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseCreateBsrilu02Info(bsrilu02Info_t *info);

该函数创建并初始化块不完全LU的求解和分析结构为默认值。

输入

|

指向块不完全LU分解的求解和分析结构的指针。 |

有关返回状态的描述,请参见cusparseStatus_t。

5.3.24. cusparseDestroyBsrilu02Info() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseDestroyBsrilu02Info(bsrilu02Info_t info);

该函数销毁并释放该结构所需的任何内存。

输入

|

求解 |

有关返回状态的描述,请参见cusparseStatus_t。

5.3.25. cusparseCreatePruneInfo() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseCreatePruneInfo(pruneInfo_t *info);

该函数创建并初始化prune结构为默认值。

输入

|

指向 |

有关返回状态的描述,请参见cusparseStatus_t。

5.3.26. cusparseDestroyPruneInfo() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseDestroyPruneInfo(pruneInfo_t info);

该函数销毁并释放该结构所需的任何内存。

输入

|

|

有关返回状态的描述,请参见cusparseStatus_t。

5.4. cuSPARSE 二级函数参考

本章介绍稀疏线性代数函数,这些函数执行稀疏矩阵与密集向量之间的运算。

5.4.1. cusparsebsrmv()

cusparseStatus_t

cusparseSbsrmv(cusparseHandle_t handle,

cusparseDirection_t dir,

cusparseOperation_t trans,

int mb,

int nb,

int nnzb,

const float* alpha,

const cusparseMatDescr_t descr,

const float* bsrVal,

const int* bsrRowPtr,

const int* bsrColInd,

int blockDim,

const float* x,

const float* beta,

float* y)

cusparseStatus_t

cusparseDbsrmv(cusparseHandle_t handle,

cusparseDirection_t dir,

cusparseOperation_t trans,

int mb,

int nb,

int nnzb,

const double* alpha,

const cusparseMatDescr_t descr,

const double* bsrVal,

const int* bsrRowPtr,

const int* bsrColInd,

int blockDim,

const double* x,

const double* beta,

double* y)

cusparseStatus_t

cusparseCbsrmv(cusparseHandle_t handle,

cusparseDirection_t dir,

cusparseOperation_t trans,

int mb,

int nb,

int nnzb,

const cuComplex* alpha,

const cusparseMatDescr_t descr,

const cuComplex* bsrVal,

const int* bsrRowPtr,

const int* bsrColInd,

int blockDim,

const cuComplex* x,

const cuComplex* beta,

cuComplex* y)

cusparseStatus_t

cusparseZbsrmv(cusparseHandle_t handle,

cusparseDirection_t dir,

cusparseOperation_t trans,

int mb,

int nb,

int nnzb,

const cuDoubleComplex* alpha,

const cusparseMatDescr_t descr,

const cuDoubleComplex* bsrVal,

const int* bsrRowPtr,

const int* bsrColInd,

int blockDim,

const cuDoubleComplex* x,

const cuDoubleComplex* beta,

cuDoubleComplex* y)

该函数执行矩阵-向量运算

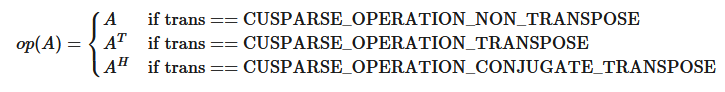

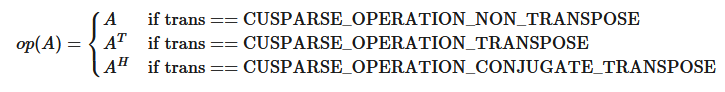

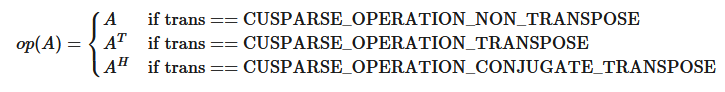

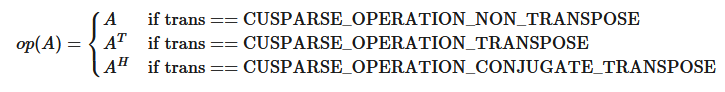

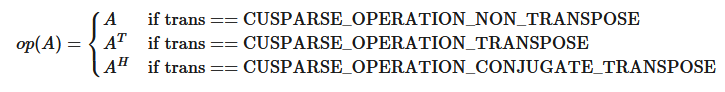

其中 \(A\text{ is an }(mb \ast blockDim) \times (nb \ast blockDim)\) 是一个稀疏矩阵,通过三个数组 bsrVal、bsrRowPtr 和 bsrColInd 以BSR存储格式定义;x 和 y 是向量;\(\alpha\text{ and }\beta\) 是标量;并且

bsrmv() 具有以下特性:

该例程不需要额外的存储空间。

该例程支持异步执行。

该例程支持CUDA图捕获。

关于bsrmv()的几点说明:

仅支持

blockDim > 1仅支持

CUSPARSE_OPERATION_NON_TRANSPOSE操作,即

仅支持

CUSPARSE_MATRIX_TYPE_GENERAL。向量

x的大小至少应为\((nb \ast blockDim)\),向量y的大小至少应为\((mb \ast blockDim)\);否则,内核可能因数组越界而返回CUSPARSE_STATUS_EXECUTION_FAILED。

例如,假设用户拥有CSR格式的数据并希望尝试bsrmv(),以下代码展示了如何在单精度下使用csr2bsr()转换和bsrmv()乘法运算。

// Suppose that A is m x n sparse matrix represented by CSR format,

// hx is a host vector of size n, and hy is also a host vector of size m.

// m and n are not multiple of blockDim.

// step 1: transform CSR to BSR with column-major order

int base, nnz;

int nnzb;

cusparseDirection_t dirA = CUSPARSE_DIRECTION_COLUMN;

int mb = (m + blockDim-1)/blockDim;

int nb = (n + blockDim-1)/blockDim;

cudaMalloc((void**)&bsrRowPtrC, sizeof(int) *(mb+1));

cusparseXcsr2bsrNnz(handle, dirA, m, n,

descrA, csrRowPtrA, csrColIndA, blockDim,

descrC, bsrRowPtrC, &nnzb);

cudaMalloc((void**)&bsrColIndC, sizeof(int)*nnzb);

cudaMalloc((void**)&bsrValC, sizeof(float)*(blockDim*blockDim)*nnzb);

cusparseScsr2bsr(handle, dirA, m, n,

descrA, csrValA, csrRowPtrA, csrColIndA, blockDim,

descrC, bsrValC, bsrRowPtrC, bsrColIndC);

// step 2: allocate vector x and vector y large enough for bsrmv

cudaMalloc((void**)&x, sizeof(float)*(nb*blockDim));

cudaMalloc((void**)&y, sizeof(float)*(mb*blockDim));

cudaMemcpy(x, hx, sizeof(float)*n, cudaMemcpyHostToDevice);

cudaMemcpy(y, hy, sizeof(float)*m, cudaMemcpyHostToDevice);

// step 3: perform bsrmv

cusparseSbsrmv(handle, dirA, transA, mb, nb, nnzb, &alpha,

descrC, bsrValC, bsrRowPtrC, bsrColIndC, blockDim, x, &beta, y);

输入

|

cuSPARSE库上下文的句柄。 |

|

块的存储格式,可以是 |

|

运算 \(\text{op}(A)\)。仅支持 |

|

矩阵 \(A\) 的块行数。 |

|

矩阵 \(A\) 的块列数。 |

|

矩阵\(A\)的非零块数量。 |

|

用于乘法的标量。 |

|

矩阵\(A\)的描述符。支持的矩阵类型是 |

|

|

|

包含每个块行起始位置及最后一个块行结束位置加1的 |

|

长度为 |

|

稀疏矩阵\(A\)的块维度,大于零。 |

|

<类型> 包含 \(nb \ast blockDim\) 个元素的向量。 |

|

|

|

输出

|

有关返回状态的描述,请参见cusparseStatus_t。

5.4.2. cusparsebsrxmv() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseSbsrxmv(cusparseHandle_t handle,

cusparseDirection_t dir,

cusparseOperation_t trans,

int sizeOfMask,

int mb,

int nb,

int nnzb,

const float* alpha,

const cusparseMatDescr_t descr,

const float* bsrVal,

const int* bsrMaskPtr,

const int* bsrRowPtr,

const int* bsrEndPtr,

const int* bsrColInd,

int blockDim,

const float* x,

const float* beta,

float* y)

cusparseStatus_t

cusparseDbsrxmv(cusparseHandle_t handle,

cusparseDirection_t dir,

cusparseOperation_t trans,

int sizeOfMask,

int mb,

int nb,

int nnzb,

const double* alpha,

const cusparseMatDescr_t descr,

const double* bsrVal,

const int* bsrMaskPtr,

const int* bsrRowPtr,

const int* bsrEndPtr,

const int* bsrColInd,

int blockDim,

const double* x,

const double* beta,

double* y)

cusparseStatus_t

cusparseCbsrxmv(cusparseHandle_t handle,

cusparseDirection_t dir,

cusparseOperation_t trans,

int sizeOfMask,

int mb,

int nb,

int nnzb,

const cuComplex* alpha,

const cusparseMatDescr_t descr,

const cuComplex* bsrVal,

const int* bsrMaskPtr,

const int* bsrRowPtr,

const int* bsrEndPtr,

const int* bsrColInd,

int blockDim,

const cuComplex* x,

const cuComplex* beta,

cuComplex* y)

cusparseStatus_t

cusparseZbsrxmv(cusparseHandle_t handle,

cusparseDirection_t dir,

cusparseOperation_t trans,

int sizeOfMask,

int mb,

int nb,

int nnzb,

const cuDoubleComplex* alpha,

const cusparseMatDescr_t descr,

const cuDoubleComplex* bsrVal,

const int* bsrMaskPtr,

const int* bsrRowPtr,

const int* bsrEndPtr,

const int* bsrColInd,

int blockDim,

const cuDoubleComplex* x,

const cuDoubleComplex* beta,

cuDoubleComplex* y)

该函数执行bsrmv和掩码操作

其中\(A\text{ 是一个 }(mb \ast blockDim) \times (nb \ast blockDim)\)稀疏矩阵,由四个数组bsrVal、bsrRowPtr、bsrEndPtr和bsrColInd以BSRX存储格式定义;x和y是向量;\(\alpha\text{~和~}\beta\)是标量;并且

掩码操作由数组bsrMaskPtr定义,该数组包含\(y\)更新后的块行索引。如果行\(i\)未在bsrMaskPtr中指定,则bsrxmv()不会触及\(A\)和\(y\)的行块\(i\)。

例如,考虑一个\(2 \times 3\)的分块矩阵\(A\):

其基于1的BSR格式(三向量形式)为:

假设我们想对矩阵\(\bar{A}\)执行以下bsrmv操作,该矩阵与\(A\)略有不同。

我们无需为新矩阵\(\bar{A}\)创建另一种BSR格式,只需保持bsrVal和bsrColInd不变,但修改bsrRowPtr并新增一个数组bsrEndPtr,该数组指向\(\bar{A}\)每行最后一个非零元素的下一个位置。

例如,以下bsrRowPtr和bsrEndPtr可以表示矩阵\(\bar{A}\):

此外,我们可以使用掩码运算符(由数组bsrMaskPtr指定)仅更新\(y\)的特定块行索引,因为\(y_{1}\)永远不会改变。在这种情况下,bsrMaskPtr\(=\) [2]且sizeOfMask=1。

mask操作符等同于以下操作:

如果某个块行不在bsrMaskPtr中,则不会对该行执行计算,并且y中的对应值保持不变。问号"?"用于表示不在bsrMaskPtr中的行块。

在这种情况下,第一行块不存在于bsrMaskPtr中,因此bsrRowPtr[0]和bsrEndPtr[0]也不会被修改。

bsrxmv() 具有以下属性:

该例程不需要额外的存储空间。

该例程支持异步执行。

该例程支持CUDA图捕获。

关于bsrxmv()的一些说明:

仅支持

blockDim > 1仅支持

CUSPARSE_OPERATION_NON_TRANSPOSE和CUSPARSE_MATRIX_TYPE_GENERAL。参数

bsrMaskPtr,bsrRowPtr,bsrEndPtr和bsrColInd与基础索引保持一致,可以是一基或零基。上面的示例是一基的。

输入

|

cuSPARSE库上下文的句柄。 |

|

块的存储格式,可以是 |

|

运算 \(\text{op}(A)\)。仅支持 |

|

更新的块行数 \(y\)。 |

|

矩阵 \(A\) 的块行数。 |

|

矩阵 \(A\) 的块列数。 |

|

矩阵\(A\)的非零块数量。 |

|

用于乘法的标量。 |

|

矩阵\(A\)的描述符。支持的矩阵类型是 |

|

|

|

包含对应已更新块行索引的 |

|

包含每个块行起始位置的 |

|

包含每个块行末尾加1的 |

|

矩阵\(A\)非零块的 |

|

稀疏矩阵\(A\)的块维度,大于零。 |

|

<类型> 包含 \(nb \ast blockDim\) 个元素的向量。 |

|

<type> 用于乘法的标量。如果 |

|

<type> 由 \(mb \ast blockDim\) 个元素组成的向量。 |

有关返回状态的描述,请参见cusparseStatus_t。

5.4.3. cusparsebsrsv2_bufferSize() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseSbsrsv2_bufferSize(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

int mb,

int nnzb,

const cusparseMatDescr_t descrA,

float* bsrValA,

const int* bsrRowPtrA,

const int* bsrColIndA,

int blockDim,

bsrsv2Info_t info,

int* pBufferSizeInBytes)

cusparseStatus_t

cusparseDbsrsv2_bufferSize(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

int mb,

int nnzb,

const cusparseMatDescr_t descrA,

double* bsrValA,

const int* bsrRowPtrA,

const int* bsrColIndA,

int blockDim,

bsrsv2Info_t info,

int* pBufferSizeInBytes)

cusparseStatus_t

cusparseCbsrsv2_bufferSize(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

int mb,

int nnzb,

const cusparseMatDescr_t descrA,

cuComplex* bsrValA,

const int* bsrRowPtrA,

const int* bsrColIndA,

int blockDim,

bsrsv2Info_t info,

int* pBufferSizeInBytes)

cusparseStatus_t

cusparseZbsrsv2_bufferSize(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

int mb,

int nnzb,

const cusparseMatDescr_t descrA,

cuDoubleComplex* bsrValA,

const int* bsrRowPtrA,

const int* bsrColIndA,

int blockDim,

bsrsv2Info_t info,

int* pBufferSizeInBytes)

该函数返回bsrsv2中使用的缓冲区大小,这是一个新的稀疏三角线性系统op(A)*y =\(\alpha\)x。

A 是一个 (mb*blockDim)x(mb*blockDim) 稀疏矩阵,通过三个数组 bsrValA、bsrRowPtrA 和 bsrColIndA 以BSR存储格式定义;x 和 y 分别是右侧向量和解向量;\(\alpha\) 是一个标量;

尽管参数trans与矩阵A的上(下)三角部分存在六种组合情况,但bsrsv2_bufferSize()会返回这些组合中所需的最大缓冲区大小。缓冲区大小取决于维度参数mb、blockDim以及矩阵非零块数量nnzb。若用户修改了矩阵,必须重新调用bsrsv2_bufferSize()以获取正确的缓冲区大小,否则可能导致段错误。

该例程不需要额外的存储空间。

该例程支持异步执行。

该例程支持CUDA图捕获。

输入

|

cuSPARSE库上下文的句柄。 |

|

块的存储格式,可以是 |

|

操作 \(\text{op}(A)\) 。 |

|

矩阵 |

|

矩阵 |

|

矩阵 |

|

|

|

包含每个块行起始位置及最后一个块行结束位置加1的 |

|

|

|

稀疏矩阵A的块维度;必须大于零。 |

输出

|

基于不同算法的内部状态记录。 |

|

用于 |

有关返回状态的描述,请参见cusparseStatus_t。

5.4.4. cusparsebsrsv2_analysis() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseSbsrsv2_analysis(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

int mb,

int nnzb,

const cusparseMatDescr_t descrA,

const float* bsrValA,

const int* bsrRowPtrA,

const int* bsrColIndA,

int blockDim,

bsrsv2Info_t info,

cusparseSolvePolicy_t policy,

void* pBuffer)

cusparseStatus_t

cusparseDbsrsv2_analysis(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

int mb,

int nnzb,

const cusparseMatDescr_t descrA,

const double* bsrValA,

const int* bsrRowPtrA,

const int* bsrColIndA,

int blockDim,

bsrsv2Info_t info,

cusparseSolvePolicy_t policy,

void* pBuffer)

cusparseStatus_t

cusparseDbsrsv2_analysis(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

int mb,

int nnzb,

const cusparseMatDescr_t descrA,

const cuComplex* bsrValA,

const int* bsrRowPtrA,

const int* bsrColIndA,

int blockDim,

bsrsv2Info_t info,

cusparseSolvePolicy_t policy,

void* pBuffer)

cusparseStatus_t

cusparseZbsrsv2_analysis(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

int mb,

int nnzb,

const cusparseMatDescr_t descrA,

const cuDoubleComplex* bsrValA,

const int* bsrRowPtrA,

const int* bsrColIndA,

int blockDim,

bsrsv2Info_t info,

cusparseSolvePolicy_t policy,

void* pBuffer)

该函数执行bsrsv2的分析阶段,这是一个新的稀疏三角线性系统op(A)*y =\(\alpha\)x。

A 是一个 (mb*blockDim)x(mb*blockDim) 稀疏矩阵,通过三个数组 bsrValA、bsrRowPtrA 和 bsrColIndA 以BSR存储格式定义;x 和 y 分别是右侧向量和解向量;\(\alpha\) 是一个标量;

BSR格式的块大小为blockDim*blockDim,根据参数dirA决定按列优先或行优先存储,该参数可以是CUSPARSE_DIRECTION_COLUMN或CUSPARSE_DIRECTION_ROW。矩阵类型必须为CUSPARSE_MATRIX_TYPE_GENERAL,填充模式和对角线类型将被忽略。

预期该函数对于给定的矩阵和特定操作类型仅执行一次。

此函数需要一个由bsrsv2_bufferSize()返回的缓冲区大小。pBuffer的地址必须是128字节的倍数。如果不是,将返回CUSPARSE_STATUS_INVALID_VALUE。

函数 bsrsv2_analysis() 会报告结构零并计算层级信息,这些信息存储在非透明结构体 info 中。层级信息可为三角求解器提取更多并行性。但 bsrsv2_solve() 无需层级信息也可执行。要禁用层级信息,用户需将三角求解器的策略指定为 CUSPARSE_SOLVE_POLICY_NO_LEVEL。

函数 bsrsv2_analysis() 总是报告第一个结构性零,即使参数 policy 设置为 CUSPARSE_SOLVE_POLICY_NO_LEVEL。如果指定了 CUSPARSE_DIAG_TYPE_UNIT,则不会报告结构性零,即使某些 j 的块 A(j,j) 缺失。用户需要调用 cusparseXbsrsv2_zeroPivot() 来了解结构性零的位置。

是否在bsrsv2_analysis()报告结构零时调用bsrsv2_solve()由用户决定。在这种情况下,用户仍可调用bsrsv2_solve(),该函数将在结构零的相同位置返回数值零。但结果x将毫无意义。

此函数需要临时额外存储空间,该空间在内部分配

如果流序内存分配器可用,该例程支持异步执行

如果流序内存分配器可用,该例程支持CUDA图捕获

输入

|

cuSPARSE库上下文的句柄。 |

|

块的存储格式,可以是 |

|

操作 \(\text{op}(A)\) 。 |

|

矩阵 |

|

矩阵 |

|

矩阵 |

|

|

|

包含每个块行起始位置及最后一个块行结束位置加1的 |

|

|

|

稀疏矩阵A的块维度,大于零。 |

|

使用 |

|

支持的策略是 |

|

由用户分配的缓冲区,其大小由 |

输出

|

在分析阶段收集的信息填充的结构(应原封不动地传递给解决阶段)。 |

有关返回状态的描述,请参见cusparseStatus_t。

5.4.5. cusparsebsrsv2_solve() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseSbsrsv2_solve(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

int mb,

int nnzb,

const float* alpha,

const cusparseMatDescr_t descrA,

const float* bsrValA,

const int* bsrRowPtrA,

const int* bsrColIndA,

int blockDim,

bsrsv2Info_t info,

const float* x,

float* y,

cusparseSolvePolicy_t policy,

void* pBuffer)

cusparseStatus_t

cusparseDbsrsv2_solve(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

int mb,

int nnzb,

const double* alpha,

const cusparseMatDescr_t descrA,

const double* bsrValA,

const int* bsrRowPtrA,

const int* bsrColIndA,

int blockDim,

bsrsv2Info_t info,

const double* x,

double* y,

cusparseSolvePolicy_t policy,

void* pBuffer)

cusparseStatus_t

cusparseCbsrsv2_solve(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

int mb,

int nnzb,

const cuComplex* alpha,

const cusparseMatDescr_t descrA,

const cuComplex* bsrValA,

const int* bsrRowPtrA,

const int* bsrColIndA,

int blockDim,

bsrsv2Info_t info,

const cuComplex* x,

cuComplex* y,

cusparseSolvePolicy_t policy,

void* pBuffer)

cusparseStatus_t

cusparseZbsrsv2_solve(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

int mb,

int nnzb,

const cuDoubleComplex* alpha,

const cusparseMatDescr_t descrA,

const cuDoubleComplex* bsrValA,

const int* bsrRowPtrA,

const int* bsrColIndA,

int blockDim,

bsrsv2Info_t info,

const cuDoubleComplex* x,

cuDoubleComplex* y,

cusparseSolvePolicy_t policy,

void* pBuffer)

该函数执行bsrsv2的求解阶段,这是一个新的稀疏三角线性系统op(A)*y =\(\alpha\)x。

A 是一个 (mb*blockDim)x(mb*blockDim) 稀疏矩阵,通过三个数组 bsrValA、bsrRowPtrA 和 bsrColIndA 以BSR存储格式定义;x 和 y 分别是右侧向量和解向量;\(\alpha\) 是一个标量;

BSR格式中的块大小为blockDim*blockDim,根据参数dirA决定按列优先或行优先存储,该参数可以是CUSPARSE_DIRECTION_COLUMN或CUSPARSE_DIRECTION_ROW。矩阵类型必须为CUSPARSE_MATRIX_TYPE_GENERAL,填充模式和对角线类型将被忽略。函数bsrsv02_solve()可以支持任意的blockDim。

对于给定的矩阵和特定操作类型,此函数可能会被执行多次。

此函数需要一个由bsrsv2_bufferSize()返回的缓冲区大小。pBuffer的地址必须是128字节的倍数。如果不是,将返回CUSPARSE_STATUS_INVALID_VALUE。

虽然bsrsv2_solve()可以在没有层级信息的情况下执行,但用户仍需注意一致性。如果bsrsv2_analysis()调用时使用策略CUSPARSE_SOLVE_POLICY_USE_LEVEL,那么bsrsv2_solve()可以在有或没有层级的情况下运行。另一方面,如果bsrsv2_analysis()调用时使用CUSPARSE_SOLVE_POLICY_NO_LEVEL,那么bsrsv2_solve()只能接受CUSPARSE_SOLVE_POLICY_NO_LEVEL;否则将返回CUSPARSE_STATUS_INVALID_VALUE。

层级信息可能不会提升性能,反而会花费额外时间进行分析。例如,三对角矩阵不具备并行性。在这种情况下,CUSPARSE_SOLVE_POLICY_NO_LEVEL的表现优于CUSPARSE_SOLVE_POLICY_USE_LEVEL。如果用户使用迭代求解器,最佳做法是先用CUSPARSE_SOLVE_POLICY_USE_LEVEL执行一次bsrsv2_analysis(),然后在首次运行时使用CUSPARSE_SOLVE_POLICY_NO_LEVEL执行bsrsv2_solve(),在第二次运行时改用CUSPARSE_SOLVE_POLICY_USE_LEVEL,最后选择较快的方式执行剩余迭代。

函数 bsrsv02_solve() 的行为与 csrsv02_solve() 相同。也就是说,bsr2csr(bsrsv02(A)) = csrsv02(bsr2csr(A))。 csrsv02_solve() 的数值零表示存在某些零元素 A(j,j)。而 bsrsv02_solve() 的数值零则表示存在某些不可逆的块 A(j,j)。

函数 bsrsv2_solve() 会报告第一个数值为零的情况,包括结构零。如果指定了 CUSPARSE_DIAG_TYPE_UNIT,即使某些 A(j,j) 不可逆,也不会报告数值零。用户需要调用 cusparseXbsrsv2_zeroPivot() 来了解数值零的位置。

如果pBuffer != NULL,该函数支持以下属性:

该例程不需要额外的存储空间。

该例程支持异步执行。

该例程支持CUDA图捕获。

例如,假设L是一个单位对角线的下三角矩阵,那么以下代码利用层级信息求解L*y=x。

// Suppose that L is m x m sparse matrix represented by BSR format,

// The number of block rows/columns is mb, and

// the number of nonzero blocks is nnzb.

// L is lower triangular with unit diagonal.

// Assumption:

// - dimension of matrix L is m(=mb*blockDim),

// - matrix L has nnz(=nnzb*blockDim*blockDim) nonzero elements,

// - handle is already created by cusparseCreate(),

// - (d_bsrRowPtr, d_bsrColInd, d_bsrVal) is BSR of L on device memory,

// - d_x is right hand side vector on device memory.

// - d_y is solution vector on device memory.

// - d_x and d_y are of size m.

cusparseMatDescr_t descr = 0;

bsrsv2Info_t info = 0;

int pBufferSize;

void *pBuffer = 0;

int structural_zero;

int numerical_zero;

const double alpha = 1.;

const cusparseSolvePolicy_t policy = CUSPARSE_SOLVE_POLICY_USE_LEVEL;

const cusparseOperation_t trans = CUSPARSE_OPERATION_NON_TRANSPOSE;

const cusparseDirection_t dir = CUSPARSE_DIRECTION_COLUMN;

// step 1: create a descriptor which contains

// - matrix L is base-1

// - matrix L is lower triangular

// - matrix L has unit diagonal, specified by parameter CUSPARSE_DIAG_TYPE_UNIT

// (L may not have all diagonal elements.)

cusparseCreateMatDescr(&descr);

cusparseSetMatIndexBase(descr, CUSPARSE_INDEX_BASE_ONE);

cusparseSetMatFillMode(descr, CUSPARSE_FILL_MODE_LOWER);

cusparseSetMatDiagType(descr, CUSPARSE_DIAG_TYPE_UNIT);

// step 2: create a empty info structure

cusparseCreateBsrsv2Info(&info);

// step 3: query how much memory used in bsrsv2, and allocate the buffer

cusparseDbsrsv2_bufferSize(handle, dir, trans, mb, nnzb, descr,

d_bsrVal, d_bsrRowPtr, d_bsrColInd, blockDim, &pBufferSize);

// pBuffer returned by cudaMalloc is automatically aligned to 128 bytes.

cudaMalloc((void**)&pBuffer, pBufferSize);

// step 4: perform analysis

cusparseDbsrsv2_analysis(handle, dir, trans, mb, nnzb, descr,

d_bsrVal, d_bsrRowPtr, d_bsrColInd, blockDim,

info, policy, pBuffer);

// L has unit diagonal, so no structural zero is reported.

status = cusparseXbsrsv2_zeroPivot(handle, info, &structural_zero);

if (CUSPARSE_STATUS_ZERO_PIVOT == status){

printf("L(%d,%d) is missing\n", structural_zero, structural_zero);

}

// step 5: solve L*y = x

cusparseDbsrsv2_solve(handle, dir, trans, mb, nnzb, &alpha, descr,

d_bsrVal, d_bsrRowPtr, d_bsrColInd, blockDim, info,

d_x, d_y, policy, pBuffer);

// L has unit diagonal, so no numerical zero is reported.

status = cusparseXbsrsv2_zeroPivot(handle, info, &numerical_zero);

if (CUSPARSE_STATUS_ZERO_PIVOT == status){

printf("L(%d,%d) is zero\n", numerical_zero, numerical_zero);

}

// step 6: free resources

cudaFree(pBuffer);

cusparseDestroyBsrsv2Info(info);

cusparseDestroyMatDescr(descr);

cusparseDestroy(handle);

输入

|

cuSPARSE库上下文的句柄。 |

|

块的存储格式,可以是 |

|

操作 \(\text{op}(A)\)。 |

|

矩阵 |

|

用于乘法的标量。 |

|

矩阵 |

|

<type> 数组,包含矩阵 |

|

包含每个块行起始位置及最后一个块行结束位置加1的 |

|

|

|

稀疏矩阵 |

|

包含分析阶段收集的信息的结构(这些信息应原封不动地传递给求解阶段)。 |

|

|

|

支持的策略是 |

|

由用户分配的缓冲区,其大小由 |

输出

|

|

有关返回状态的描述,请参见cusparseStatus_t。

5.4.6. cusparseXbsrsv2_zeroPivot() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseXbsrsv2_zeroPivot(cusparseHandle_t handle,

bsrsv2Info_t info,

int* position)

如果返回的错误代码是CUSPARSE_STATUS_ZERO_PIVOT,position=j表示A(j,j)是结构零或数值零(奇异块)。否则position=-1。

position 可以是基于0或基于1的索引,与矩阵的索引方式相同。

函数 cusparseXbsrsv2_zeroPivot() 是一个阻塞调用。它会调用 cudaDeviceSynchronize() 来确保之前的所有内核操作都已完成。

position可以位于主机内存或设备内存中。用户可以通过cusparseSetPointerMode()设置合适的模式。

该例程不需要额外的存储空间

如果流序内存分配器可用,该例程支持异步执行

如果流序内存分配器可用,该例程支持CUDA图捕获

输入

|

cuSPARSE库上下文的句柄。 |

|

|

输出

|

如果没有结构或数值上的零值, |

有关返回状态的描述,请参见cusparseStatus_t

5.4.7. cusparsegemvi() [已弃用]

> 此例程将在未来的主要版本中移除。

cusparseStatus_t

cusparseSgemvi_bufferSize(cusparseHandle_t handle,

cusparseOperation_t transA,

int m,

int n,

int nnz,

int* pBufferSize)

cusparseStatus_t

cusparseDgemvi_bufferSize(cusparseHandle_t handle,

cusparseOperation_t transA,

int m,

int n,

int nnz,

int* pBufferSize)

cusparseStatus_t

cusparseCgemvi_bufferSize(cusparseHandle_t handle,

cusparseOperation_t transA,

int m,

int n,

int nnz,

int* pBufferSize)

cusparseStatus_t

cusparseZgemvi_bufferSize(cusparseHandle_t handle,

cusparseOperation_t transA,

int m,

int n,

int nnz,

int* pBufferSize)

cusparseStatus_t

cusparseSgemvi(cusparseHandle_t handle,

cusparseOperation_t transA,

int m,

int n,

const float* alpha,

const float* A,

int lda,

int nnz,

const float* x,

const int* xInd,

const float* beta,

float* y,

cusparseIndexBase_t idxBase,

void* pBuffer)

cusparseStatus_t

cusparseDgemvi(cusparseHandle_t handle,

cusparseOperation_t transA,

int m,

int n,

const double* alpha,

const double* A,

int lda,

int nnz,

const double* x,

const int* xInd,

const double* beta,

double* y,

cusparseIndexBase_t idxBase,

void* pBuffer)

cusparseStatus_t

cusparseCgemvi(cusparseHandle_t handle,

cusparseOperation_t transA,

int m,

int n,

const cuComplex* alpha,

const cuComplex* A,

int lda,

int nnz,

const cuComplex* x,

const int* xInd,

const cuComplex* beta,

cuComplex* y,

cusparseIndexBase_t idxBase,

void* pBuffer)

cusparseStatus_t

cusparseZgemvi(cusparseHandle_t handle,

cusparseOperation_t transA,

int m,

int n,

const cuDoubleComplex* alpha,

const cuDoubleComplex* A,

int lda,

int nnz,

const cuDoubleComplex* x,

const int* xInd,

const cuDoubleComplex* beta,

cuDoubleComplex* y,

cusparseIndexBase_t idxBase,

void* pBuffer)

该函数执行矩阵-向量运算

A 是一个 \(m \times n\) 的稠密矩阵,稀疏向量 x 通过两个长度为 nnz 的数组 xVal, xInd 以稀疏存储格式定义,y 是一个稠密向量;\(\alpha \;\) 和 \(\beta \;\) 是标量;且

为了简化实现,我们目前尚未对转置多重情况进行优化。对于对此情况感兴趣的用户,我们推荐以下方法。

使用

csr2csc()函数之一将矩阵从CSR格式转换为CSC格式。请注意,通过交换结果的行和列,您实际上是在对矩阵进行转置。-

调用

gemvi()函数,将cusparseOperation_t参数设置为CUSPARSE_OPERATION_NON_TRANSPOSE,并使用以CSC格式存储的矩阵行列互换版本。这(隐式地)实现了向量与原始CSR格式矩阵转置的乘法运算。该例程不需要额外的存储空间

该例程支持异步执行

该例程支持CUDA图捕获

函数 cusparse 返回在 cusparse 中使用的缓冲区大小。

输入

|

cuSPARSE库上下文的句柄。 |

|

操作 \(\text{op}(A)\)。 |

|

矩阵 |

|

矩阵 |

|

用于乘法的标量。 |

|

指向稠密矩阵 |

|

|

|

向量 |

|

|

|

|

|

<type> 用于乘法的标量。如果 |

|

|

|

0或1,分别表示基于0或基于1的索引。 |

|

缓冲区在 |

|

工作空间缓冲区。 |

输出

|

有关返回状态的描述,请参见cusparseStatus_t。

5.5. cuSPARSE 三级函数参考

本章介绍稀疏线性代数函数,这些函数在稀疏矩阵与(通常为高维)稠密矩阵之间执行运算。

5.5.1. cusparsebsrmm() [已弃用]

> 此例程将在未来的主要版本中移除。 请改用支持BSR矩阵的cusparseSpMM()函数。

cusparseStatus_t

cusparseSbsrmm(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

cusparseOperation_t transB,

int mb,

int n,

int kb,

int nnzb,

const float* alpha,

const cusparseMatDescr_t descrA,

const float* bsrValA,

const int* bsrRowPtrA,

const int* bsrColIndA,

int blockDim,

const float* B,

int ldb,

const float* beta,

float* C,

int ldc)

cusparseStatus_t

cusparseDbsrmm(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

cusparseOperation_t transB,

int mb,

int n,

int kb,

int nnzb,

const double* alpha,

const cusparseMatDescr_t descrA,

const double* bsrValA,

const int* bsrRowPtrA,

const int* bsrColIndA,

int blockDim,

const double* B,

int ldb,

const double* beta,

double* C,

int ldc)

cusparseStatus_t

cusparseCbsrmm(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

cusparseOperation_t transB,

int mb,

int n,

int kb,

int nnzb,

const cuComplex* alpha,

const cusparseMatDescr_t descrA,

const cuComplex* bsrValA,

const int* bsrRowPtrA,

const int* bsrColIndA,

int blockDim,

const cuComplex* B,

int ldb,

const cuComplex* beta,

cuComplex* C,

int ldc)

cusparseStatus_t

cusparseZbsrmm(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

cusparseOperation_t transB,

int mb,

int n,

int kb,

int nnzb,

const cuDoubleComplex* alpha,

const cusparseMatDescr_t descrA,

const cuDoubleComplex* bsrValA,

const int* bsrRowPtrA,

const int* bsrColIndA,

int blockDim,

const cuDoubleComplex* B,

int ldb,

const cuDoubleComplex* beta,

cuDoubleComplex* C,

int ldc)

该函数执行以下矩阵-矩阵运算之一:

A 是一个 \(mb \times kb\) 稀疏矩阵,通过三个数组 bsrValA、bsrRowPtrA 和 bsrColIndA 以BSR存储格式定义;B 和 C 是稠密矩阵;\(\alpha\text{~和~}\beta\) 是标量;并且

和

该函数有以下限制:

仅支持

CUSPARSE_MATRIX_TYPE_GENERAL矩阵类型仅支持

blockDim > 1如果

blockDim≤ 4,则 max(mb)/max(n) = 524,272如果4 <

blockDim≤ 8,则最大(mb) = 524,272,最大(n) = 262,136如果

blockDim大于 8,则 m 小于 65,535 且最大(n) = 262,136

使用transpose(B)的动机是为了改善矩阵B的内存访问效率。当矩阵B采用列优先存储时,A*transpose(B)的计算模式等同于矩阵B采用行优先存储时的A*B运算。

在实践中,迭代求解器或特征值求解器中的操作都不会使用A*transpose(B)。不过,我们可以执行A*transpose(transpose(B)),这与A*B是等价的。例如,假设A的维度是mb*kb,B的维度是k*n,而C的维度是m*n,以下代码展示了cusparseDbsrmm()的用法。

// A is mb*kb, B is k*n and C is m*n

const int m = mb*blockSize;

const int k = kb*blockSize;

const int ldb_B = k; // leading dimension of B

const int ldc = m; // leading dimension of C

// perform C:=alpha*A*B + beta*C

cusparseSetMatType(descrA, CUSPARSE_MATRIX_TYPE_GENERAL );

cusparseDbsrmm(cusparse_handle,

CUSPARSE_DIRECTION_COLUMN,

CUSPARSE_OPERATION_NON_TRANSPOSE,

CUSPARSE_OPERATION_NON_TRANSPOSE,

mb, n, kb, nnzb, alpha,

descrA, bsrValA, bsrRowPtrA, bsrColIndA, blockSize,

B, ldb_B,

beta, C, ldc);

我们的建议不是直接使用A*B,而是先调用cublas将B转置为Bt,然后再执行A*transpose(Bt)。

// step 1: Bt := transpose(B)

const int m = mb*blockSize;

const int k = kb*blockSize;

double *Bt;

const int ldb_Bt = n; // leading dimension of Bt

cudaMalloc((void**)&Bt, sizeof(double)*ldb_Bt*k);

double one = 1.0;

double zero = 0.0;

cublasSetPointerMode(cublas_handle, CUBLAS_POINTER_MODE_HOST);

cublasDgeam(cublas_handle, CUBLAS_OP_T, CUBLAS_OP_T,

n, k, &one, B, int ldb_B, &zero, B, int ldb_B, Bt, ldb_Bt);

// step 2: perform C:=alpha*A*transpose(Bt) + beta*C

cusparseDbsrmm(cusparse_handle,

CUSPARSE_DIRECTION_COLUMN,

CUSPARSE_OPERATION_NON_TRANSPOSE,

CUSPARSE_OPERATION_TRANSPOSE,

mb, n, kb, nnzb, alpha,

descrA, bsrValA, bsrRowPtrA, bsrColIndA, blockSize,

Bt, ldb_Bt,

beta, C, ldc);

bsrmm() 具有以下属性:

该例程不需要额外的存储空间。

该例程支持异步执行。

该例程支持CUDA图捕获。

输入

|

cuSPARSE库上下文的句柄。 |

|

块的存储格式,可以是 |

|

操作 |

|

操作 |

|

稀疏矩阵 |

|

稠密矩阵 |

|

稀疏矩阵 |

|

稀疏矩阵 |

|

用于乘法的标量。 |

|

矩阵 |

|

<type> 矩阵 |

|

包含每个块行起始位置及最后一个块行结束位置加1的 |

|

|

|

稀疏矩阵 |

|

维度数组 |

|

|

|

|

|

维度数组 |

|

|

输出

|

|

有关返回状态的描述,请参见cusparseStatus_t。

5.5.2. cusparsebsrsm2_bufferSize() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseSbsrsm2_bufferSize(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

cusparseOperation_t transX,

int mb,

int n,

int nnzb,

const cusparseMatDescr_t descrA,

float* bsrSortedValA,

const int* bsrSortedRowPtrA,

const int* bsrSortedColIndA,

int blockDim,

bsrsm2Info_t info,

int* pBufferSizeInBytes)

cusparseStatus_t

cusparseDbsrsm2_bufferSize(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

cusparseOperation_t transX,

int mb,

int n,

int nnzb,

const cusparseMatDescr_t descrA,

double* bsrSortedValA,

const int* bsrSortedRowPtrA,

const int* bsrSortedColIndA,

int blockDim,

bsrsm2Info_t info,

int* pBufferSizeInBytes)

cusparseStatus_t

cusparseCbsrsm2_bufferSize(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

cusparseOperation_t transX,

int mb,

int n,

int nnzb,

const cusparseMatDescr_t descrA,

cuComplex* bsrSortedValA,

const int* bsrSortedRowPtrA,

const int* bsrSortedColIndA,

int blockDim,

bsrsm2Info_t info,

int* pBufferSizeInBytes)

cusparseStatus_t

cusparseZbsrsm2_bufferSize(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

cusparseOperation_t transX,

int mb,

int n,

int nnzb,

const cusparseMatDescr_t descrA,

cuDoubleComplex* bsrSortedValA,

const int* bsrSortedRowPtrA,

const int* bsrSortedColIndA,

int blockDim,

bsrsm2Info_t info,

int* pBufferSizeInBytes)

该函数返回bsrsm2()中使用的缓冲区大小,这是一个新的稀疏三角线性系统op(A)*op(X)=\(\alpha\)op(B)。

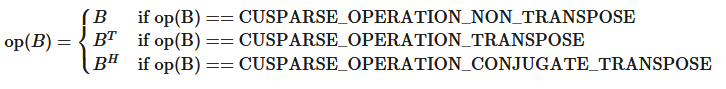

A 是一个 (mb*blockDim)x(mb*blockDim) 稀疏矩阵,通过三个数组 bsrValA、bsrRowPtrA 和 bsrColIndA 以BSR存储格式定义;B 和 X 分别是右侧矩阵和解矩阵;\(\alpha\) 是一个标量;

尽管参数trans与矩阵A的上(下)三角部分存在六种组合情况,但bsrsm2_bufferSize()会返回这些组合中所需的缓冲区最大尺寸。缓冲区大小取决于维度mb,blockDim以及矩阵非零元素数量nnzb。若用户修改了矩阵,必须重新调用bsrsm2_bufferSize()获取正确的缓冲区大小,否则可能导致段错误。

该例程不需要额外的存储空间。

该例程支持异步执行。

该例程支持CUDA图捕获。

输入

|

cuSPARSE库上下文的句柄。 |

|

块的存储格式,可以是 |

|

操作 |

|

操作 |

|

矩阵 |

|

矩阵 |

|

矩阵 |

|

矩阵 |

|

<type> 矩阵 |

|

包含每个块行起始位置及最后一个块行结束位置加1的 |

|

|

|

稀疏矩阵 |

输出

|

根据不同算法记录内部状态。 |

|

在 |

有关返回状态的描述,请参见cusparseStatus_t。

5.5.3. cusparsebsrsm2_analysis() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseSbsrsm2_analysis(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

cusparseOperation_t transX,

int mb,

int n,

int nnzb,

const cusparseMatDescr_t descrA,

const float* bsrSortedVal,

const int* bsrSortedRowPtr,

const int* bsrSortedColInd,

int blockDim,

bsrsm2Info_t info,

cusparseSolvePolicy_t policy,

void* pBuffer)

cusparseStatus_t

cusparseDbsrsm2_analysis(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

cusparseOperation_t transX,

int mb,

int n,

int nnzb,

const cusparseMatDescr_t descrA,

const double* bsrSortedVal,

const int* bsrSortedRowPtr,

const int* bsrSortedColInd,

int blockDim,

bsrsm2Info_t info,

cusparseSolvePolicy_t policy,

void* pBuffer)

cusparseStatus_t

cusparseCbsrsm2_analysis(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

cusparseOperation_t transX,

int mb,

int n,

int nnzb,

const cusparseMatDescr_t descrA,

const cuComplex* bsrSortedVal,

const int* bsrSortedRowPtr,

const int* bsrSortedColInd,

int blockDim,

bsrsm2Info_t info,

cusparseSolvePolicy_t policy,

void* pBuffer)

cusparseStatus_t

cusparseZbsrsm2_analysis(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

cusparseOperation_t transX,

int mb,

int n,

int nnzb,

const cusparseMatDescr_t descrA,

const cuDoubleComplex* bsrSortedVal,

const int* bsrSortedRowPtr,

const int* bsrSortedColInd,

int blockDim,

bsrsm2Info_t info,

cusparseSolvePolicy_t policy,

void* pBuffer)

此函数执行bsrsm2()的分析阶段,这是一个新的稀疏三角线性系统op(A)*op(X) =\(\alpha\)op(B)。

A 是一个 (mb*blockDim)x(mb*blockDim) 稀疏矩阵,通过三个数组 bsrValA、bsrRowPtrA 和 bsrColIndA 以BSR存储格式定义;B 和 X 分别是右侧矩阵和解矩阵;\(\alpha\) 是一个标量;

和

且 op(B) 和 op(X) 相等。

BSR格式的块大小为blockDim*blockDim,根据参数dirA决定按列优先或行优先存储,该参数可以是CUSPARSE_DIRECTION_ROW或CUSPARSE_DIRECTION_COLUMN。矩阵类型必须为CUSPARSE_MATRIX_TYPE_GENERAL,填充模式和对角线类型将被忽略。

预期该函数对于给定的矩阵和特定操作类型仅执行一次。

此函数需要由bsrsm2_bufferSize()返回的缓冲区大小。pBuffer的地址必须是128字节的倍数。否则,将返回CUSPARSE_STATUS_INVALID_VALUE。

函数 bsrsm2_analysis() 会报告结构零并计算存储在非透明结构 info 中的层级信息。该层级信息可在三角求解器中提取更多并行性。但 bsrsm2_solve() 可不依赖层级信息执行。如需禁用层级信息,用户需将三角求解器的策略指定为 CUSPARSE_SOLVE_POLICY_NO_LEVEL。

函数 bsrsm2_analysis() 总是会报告第一个结构零值,即使参数 policy 设置为 CUSPARSE_SOLVE_POLICY_NO_LEVEL。此外,如果指定了 CUSPARSE_DIAG_TYPE_UNIT,即使某些 j 的块 A(j,j) 缺失,也不会报告结构零值。用户必须调用 cusparseXbsrsm2_query_zero_pivot() 来了解结构零值的位置。

如果bsrsm2_analysis()报告存在结构零值,求解过程将在相同位置返回数值零,但该结果X没有实际意义。

此函数需要临时额外存储空间,该空间在内部分配。

如果流序内存分配器可用,该例程支持异步执行。

如果流序内存分配器可用,该例程支持CUDA图捕获。

输入

|

cuSPARSE库上下文的句柄。 |

|

块的存储格式,可以是 |

|

操作 |

|

操作 |

|

矩阵 |

|

矩阵 |

|

矩阵 |

|

矩阵 |

|

<type> 矩阵 |

|

包含每个块行起始位置及最后一个块行结束位置加1的 |

|

|

|

稀疏矩阵 |

|

使用 |

|

支持的政策有 |

|

由用户分配的缓冲区;大小由 |

输出

|

在分析阶段收集的信息填充的结构(应原封不动地传递给解决阶段)。 |

有关返回状态的描述,请参见cusparseStatus_t。

5.5.4. cusparsebsrsm2_solve() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseSbsrsm2_solve(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

cusparseOperation_t transX,

int mb,

int n,

int nnzb,

const float* alpha,

const cusparseMatDescr_t descrA,

const float* bsrSortedVal,

const int* bsrSortedRowPtr,

const int* bsrSortedColInd,

int blockDim,

bsrsm2Info_t info,

const float* B,

int ldb,

float* X,

int ldx,

cusparseSolvePolicy_t policy,

void* pBuffer)

cusparseStatus_t

cusparseDbsrsm2_solve(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

cusparseOperation_t transX,

int mb,

int n,

int nnzb,

const double* alpha,

const cusparseMatDescr_t descrA,

const double* bsrSortedVal,

const int* bsrSortedRowPtr,

const int* bsrSortedColInd,

int blockDim,

bsrsm2Info_t info,

const double* B,

int ldb,

double* X,

int ldx,

cusparseSolvePolicy_t policy,

void* pBuffer)

cusparseStatus_t

cusparseCbsrsm2_solve(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

cusparseOperation_t transX,

int mb,

int n,

int nnzb,

const cuComplex* alpha,

const cusparseMatDescr_t descrA,

const cuComplex* bsrSortedVal,

const int* bsrSortedRowPtr,

const int* bsrSortedColInd,

int blockDim,

bsrsm2Info_t info,

const cuComplex* B,

int ldb,

cuComplex* X,

int ldx,

cusparseSolvePolicy_t policy,

void* pBuffer)

cusparseStatus_t

cusparseZbsrsm2_solve(cusparseHandle_t handle,

cusparseDirection_t dirA,

cusparseOperation_t transA,

cusparseOperation_t transX,

int mb,

int n,

int nnzb,

const cuDoubleComplex* alpha,

const cusparseMatDescr_t descrA,

const cuDoubleComplex* bsrSortedVal,

const int* bsrSortedRowPtr,

const int* bsrSortedColInd,

int blockDim,

bsrsm2Info_t info,

const cuDoubleComplex* B,

int ldb,

cuDoubleComplex* X,

int ldx,

cusparseSolvePolicy_t policy,

void* pBuffer)

该函数执行稀疏三角线性系统解的求解阶段:

A 是一个 (mb*blockDim)x(mb*blockDim) 稀疏矩阵,通过三个数组 bsrValA、bsrRowPtrA 和 bsrColIndA 以BSR存储格式定义;B 和 X 分别是右侧矩阵和解矩阵;\(\alpha\) 是一个标量,且

和

仅支持 op(A)=A。

op(B) 和 op(X) 必须以相同的方式执行。换句话说,如果 op(B)=B,则 op(X)=X。

BSR格式的块大小为blockDim*blockDim,根据参数dirA决定以列优先或行优先方式存储,该参数可以是CUSPARSE_DIRECTION_ROW或CUSPARSE_DIRECTION_COLUMN。矩阵类型必须为CUSPARSE_MATRIX_TYPE_GENERAL,填充模式和对角线类型将被忽略。函数bsrsm02_solve()可以支持任意blockDim值。

对于给定的矩阵和特定操作类型,此函数可能会被执行多次。

此函数需要由bsrsm2_bufferSize()返回的缓冲区大小。pBuffer的地址必须是128字节的倍数。如果不是,将返回CUSPARSE_STATUS_INVALID_VALUE。

虽然bsrsm2_solve()可以在没有层级信息的情况下执行,但用户仍需注意一致性。如果bsrsm2_analysis()调用时使用策略CUSPARSE_SOLVE_POLICY_USE_LEVEL,则bsrsm2_solve()可以在有或没有层级的情况下运行。另一方面,如果bsrsm2_analysis()调用时使用CUSPARSE_SOLVE_POLICY_NO_LEVEL,则bsrsm2_solve()只能接受CUSPARSE_SOLVE_POLICY_NO_LEVEL;否则将返回CUSPARSE_STATUS_INVALID_VALUE。

函数 bsrsm02_solve() 的行为与 bsrsv02_solve() 相同,会报告第一个数值为零的情况,包括结构零。用户必须调用 cusparseXbsrsm2_query_zero_pivot() 来了解数值零的位置。

transpose(X)的动机是为了优化矩阵X的内存访问。当矩阵X采用列优先存储时,transpose(X)的计算模式等同于采用行优先存储的矩阵X。

支持原地操作,要求B和X指向相同的内存块,且ldb=ldx。

如果pBuffer != NULL,该函数支持以下属性:

该例程不需要额外的存储空间。

该例程支持异步执行。

该例程支持CUDA图捕获。

输入

|

cuSPARSE库上下文的句柄。 |

|

块的存储格式,可以是 |

|

操作 |

|

操作 |

|

矩阵 |

|

矩阵 |

|

矩阵 |

|

用于乘法的标量。 |

|

矩阵 |

|

|

|

包含每个块行起始位置及最后一个块行结束位置加1的 |

|

|

|

稀疏矩阵 |

|

使用 |

|

|

|

|

|

|

|

支持的策略是 |

|

由用户分配的缓冲区;大小由 |

输出

|

|

有关返回状态的描述,请参见cusparseStatus_t。

5.5.5. cusparseXbsrsm2_zeroPivot() [已弃用]

> 该例程将在下一个主要版本中移除

cusparseStatus_t

cusparseXbsrsm2_zeroPivot(cusparseHandle_t handle,

bsrsm2Info_t info,

int* position)

如果返回的错误代码是CUSPARSE_STATUS_ZERO_PIVOT,position=j表示A(j,j)是结构零或数值零(奇异块)。否则position=-1。

position 可以是基于0或基于1的索引,与矩阵的索引方式相同。

函数 cusparseXbsrsm2_zeroPivot() 是一个阻塞调用。它会调用 cudaDeviceSynchronize() 来确保之前的所有内核操作都已完成。

position可以位于主机内存或设备内存中。用户可以通过cusparseSetPointerMode()设置合适的模式。

该例程不需要额外的存储空间。

如果流序内存分配器可用,该例程支持异步执行。

如果流序内存分配器可用,该例程支持CUDA图捕获。

输入

|

cuSPARSE库上下文的句柄。 |

|

|

输出

|

如果没有结构或数值上的零值, |

有关返回状态的描述,请参见cusparseStatus_t。

5.6. cuSPARSE 额外函数参考

本章介绍用于操作稀疏矩阵的额外例程。

5.6.1. cusparsecsrgeam2()

cusparseStatus_t

cusparseScsrgeam2_bufferSizeExt(cusparseHandle_t handle,

int m,

int n,

const float* alpha,

const cusparseMatDescr_t descrA,

int nnzA,

const float* csrSortedValA,

const int* csrSortedRowPtrA,

const int* csrSortedColIndA,

const float* beta,

const cusparseMatDescr_t descrB,

int nnzB,

const float* csrSortedValB,

const int* csrSortedRowPtrB,

const int* csrSortedColIndB,

const cusparseMatDescr_t descrC,

const float* csrSortedValC,

const int* csrSortedRowPtrC,

const int* csrSortedColIndC,

size_t* pBufferSizeInBytes)

cusparseStatus_t

cusparseDcsrgeam2_bufferSizeExt(cusparseHandle_t handle,

int m,

int n,

const double* alpha,

const cusparseMatDescr_t descrA,

int nnzA,

const double* csrSortedValA,

const int* csrSortedRowPtrA,

const int* csrSortedColIndA,

const double* beta,

const cusparseMatDescr_t descrB,

int nnzB,

const double* csrSortedValB,

const int* csrSortedRowPtrB,

const int* csrSortedColIndB,

const cusparseMatDescr_t descrC,

const double* csrSortedValC,

const int* csrSortedRowPtrC,

const int* csrSortedColIndC,

size_t* pBufferSizeInBytes)

cusparseStatus_t

cusparseCcsrgeam2_bufferSizeExt(cusparseHandle_t handle,

int m,

int n,

const cuComplex* alpha,

const cusparseMatDescr_t descrA,

int nnzA,

const cuComplex* csrSortedValA,

const int* csrSortedRowPtrA,

const int* csrSortedColIndA,

const cuComplex* beta,

const cusparseMatDescr_t descrB,

int nnzB,

const cuComplex* csrSortedValB,

const int* csrSortedRowPtrB,

const int* csrSortedColIndB,

const cusparseMatDescr_t descrC,

const cuComplex* csrSortedValC,

const int* csrSortedRowPtrC,

const int* csrSortedColIndC,

size_t* pBufferSizeInBytes)

cusparseStatus_t

cusparseZcsrgeam2_bufferSizeExt(cusparseHandle_t handle,

int m,

int n,

const cuDoubleComplex* alpha,

const cusparseMatDescr_t descrA,

int nnzA,

const cuDoubleComplex* csrSortedValA,

const int* csrSortedRowPtrA,

const int* csrSortedColIndA,

const cuDoubleComplex* beta,

const cusparseMatDescr_t descrB,

int nnzB,

const cuDoubleComplex* csrSortedValB,

const int* csrSortedRowPtrB,

const int* csrSortedColIndB,

const cusparseMatDescr_t descrC,

const cuDoubleComplex* csrSortedValC,

const int* csrSortedRowPtrC,

const int* csrSortedColIndC,

size_t* pBufferSizeInBytes)

cusparseStatus_t

cusparseXcsrgeam2Nnz(cusparseHandle_t handle,

int m,

int n,

const cusparseMatDescr_t descrA,

int nnzA,

const int* csrSortedRowPtrA,

const int* csrSortedColIndA,

const cusparseMatDescr_t descrB,

int nnzB,

const int* csrSortedRowPtrB,

const int* csrSortedColIndB,

const cusparseMatDescr_t descrC,

int* csrSortedRowPtrC,

int* nnzTotalDevHostPtr,

void* workspace)

cusparseStatus_t

cusparseScsrgeam2(cusparseHandle_t handle,

int m,

int n,

const float* alpha,

const cusparseMatDescr_t descrA,

int nnzA,

const float* csrSortedValA,

const int* csrSortedRowPtrA,

const int* csrSortedColIndA,

const float* beta,

const cusparseMatDescr_t descrB,

int nnzB,

const float* csrSortedValB,

const int* csrSortedRowPtrB,

const int* csrSortedColIndB,

const cusparseMatDescr_t descrC,

float* csrSortedValC,

int* csrSortedRowPtrC,

int* csrSortedColIndC,

void* pBuffer)

cusparseStatus_t

cusparseDcsrgeam2(cusparseHandle_t handle,

int m,

int n,

const double* alpha,

const cusparseMatDescr_t descrA,

int nnzA,

const double* csrSortedValA,

const int* csrSortedRowPtrA,

const int* csrSortedColIndA,

const double* beta,

const cusparseMatDescr_t descrB,

int nnzB,

const double* csrSortedValB,

const int* csrSortedRowPtrB,

const int* csrSortedColIndB,

const cusparseMatDescr_t descrC,

double* csrSortedValC,

int* csrSortedRowPtrC,

int* csrSortedColIndC,

void* pBuffer)

cusparseStatus_t

cusparseCcsrgeam2(cusparseHandle_t handle,

int m,

int n,

const cuComplex* alpha,

const cusparseMatDescr_t descrA,

int nnzA,

const cuComplex* csrSortedValA,

const int* csrSortedRowPtrA,

const int* csrSortedColIndA,

const cuComplex* beta,

const cusparseMatDescr_t descrB,

int nnzB,

const cuComplex* csrSortedValB,

const int* csrSortedRowPtrB,

const int* csrSortedColIndB,

const cusparseMatDescr_t descrC,

cuComplex* csrSortedValC,

int* csrSortedRowPtrC,

int* csrSortedColIndC,

void* pBuffer)

cusparseStatus_t

cusparseZcsrgeam2(cusparseHandle_t handle,

int m,

int n,

const cuDoubleComplex* alpha,

const cusparseMatDescr_t descrA,

int nnzA,

const cuDoubleComplex* csrSortedValA,

const int* csrSortedRowPtrA,

const int* csrSortedColIndA,

const cuDoubleComplex* beta,

const cusparseMatDescr_t descrB,

int nnzB,

const cuDoubleComplex* csrSortedValB,

const int* csrSortedRowPtrB,

const int* csrSortedColIndB,

const cusparseMatDescr_t descrC,

cuDoubleComplex* csrSortedValC,

int* csrSortedRowPtrC,

int* csrSortedColIndC,

void* pBuffer)

该函数执行以下矩阵-矩阵运算

其中A、B和C是\(m \times n\)稀疏矩阵(分别由三个数组csrValA|csrValB|csrValC、csrRowPtrA|csrRowPtrB|csrRowPtrC和csrColIndA|csrColIndB|csrcolIndC以CSR存储格式定义),\(\alpha\text{~和~}\beta\)为标量。由于A和B具有不同的稀疏模式,cuSPARSE采用两步法完成稀疏矩阵C的计算。第一步,用户分配m+1个元素的csrRowPtrC数组,并调用函数cusparseXcsrgeam2Nnz()来确定csrRowPtrC及非零元素总数。第二步,用户从(nnzC=*nnzTotalDevHostPtr)或(nnzC=csrRowPtrC(m)-csrRowPtrC(0))获取矩阵C的非零元素数量nnzC,然后分别分配nnzC个元素的csrValC, csrColIndC数组,最终调用函数cusparse[S|D|C|Z]csrgeam2()完成矩阵C的计算。

一般流程如下:

int baseC, nnzC;

/* alpha, nnzTotalDevHostPtr points to host memory */

size_t BufferSizeInBytes;

char *buffer = NULL;

int *nnzTotalDevHostPtr = &nnzC;

cusparseSetPointerMode(handle, CUSPARSE_POINTER_MODE_HOST);

cudaMalloc((void**)&csrRowPtrC, sizeof(int)*(m+1));

/* prepare buffer */

cusparseScsrgeam2_bufferSizeExt(handle, m, n,

alpha,

descrA, nnzA,

csrValA, csrRowPtrA, csrColIndA,

beta,

descrB, nnzB,

csrValB, csrRowPtrB, csrColIndB,

descrC,

csrValC, csrRowPtrC, csrColIndC

&bufferSizeInBytes

);

cudaMalloc((void**)&buffer, sizeof(char)*bufferSizeInBytes);

cusparseXcsrgeam2Nnz(handle, m, n,

descrA, nnzA, csrRowPtrA, csrColIndA,