微调大型语言模型

微调在利用大语言模型(LLM)完成特定任务中起着关键作用。它是连接通用预训练模型与专业领域复杂性的桥梁。通过微调,我们可以调整模型的语言理解能力、上下文处理及输出结果,使其与我们的任务需求相匹配。这一过程显著提升了大语言模型的适用性和性能表现,使其成为各类人工智能应用中不可或缺的工具。

通过探索微调过程并理解其在大型语言模型中的重要性,您将获得针对特定任务优化大型语言模型所需的知识和实践技能,最终推动人工智能和机器学习领域可能性的边界。

本文节选自Human Signal的免费电子书《LLM微调必备指南》。如果您想了解更多关于LLM微调的内容,可以在此下载本书。

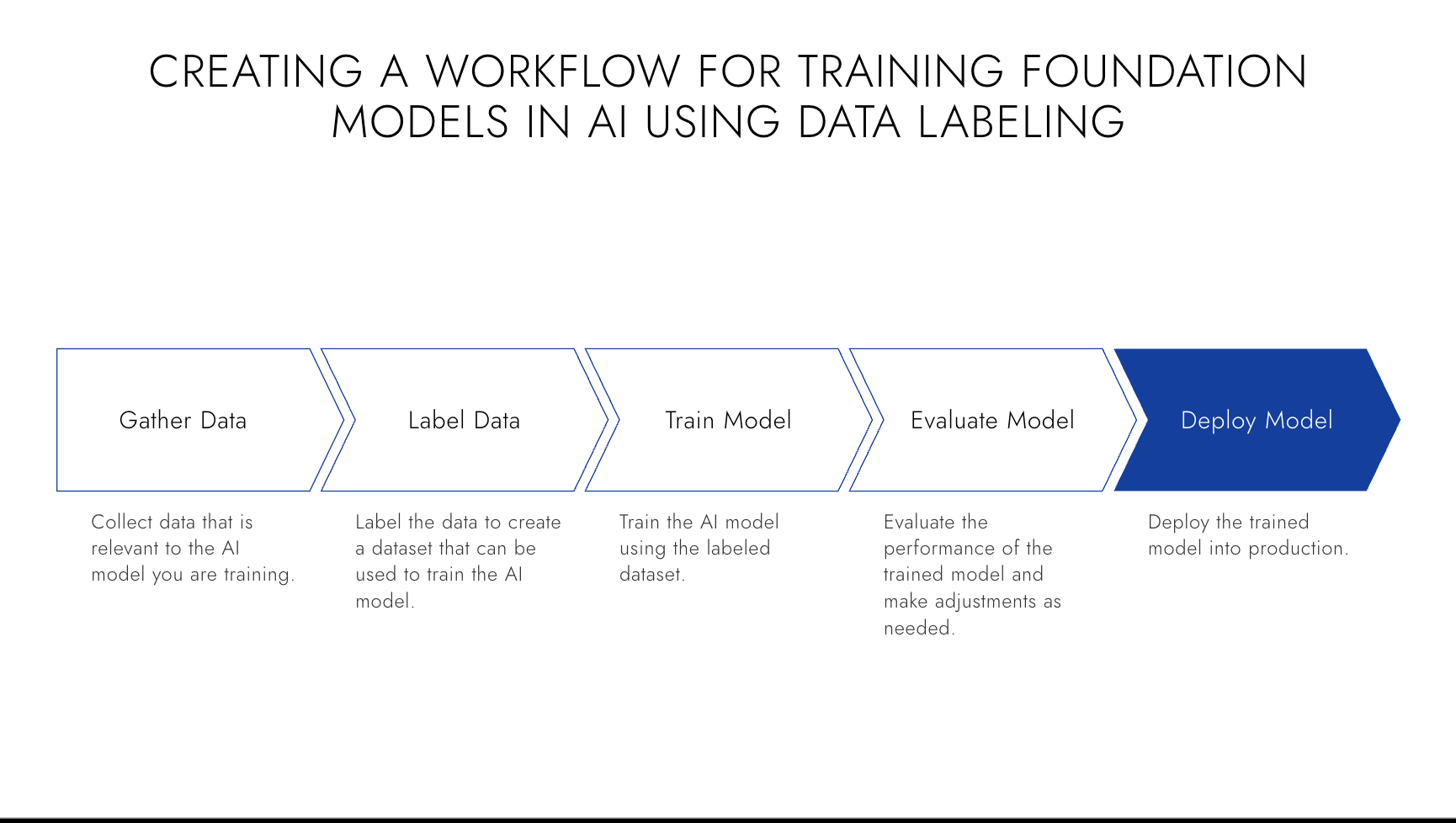

微调过程

微调是一个变革性的过程,它使我们能够针对特定任务优化预训练模型,从而提高性能并增强效率。本节将深入探讨微调过程的复杂性,将其分解为关键组成部分,并对每个步骤进行全面解释。

微调的目标

微调的核心目标是对预训练模型进行定制,使其能更有效地处理特定任务。虽然预训练模型具备出色的语言理解能力,但它们缺乏针对具体任务的知识和上下文。通过调整模型参数并让其接触任务相关数据,微调能够弥合这一差距。这样,模型就能学习目标任务的复杂性,从而做出更准确的预测或生成更相关的输出。

数据准备

数据准备在微调过程中起着至关重要的作用。用于微调的数据质量和相关性直接影响模型的性能。收集或创建代表目标任务的数据集至关重要,并且需要包含足够的示例供模型学习。数据集应涵盖各种场景并保持平衡以避免偏差。可能还需要进行预处理步骤,如清洗、分词和归一化,以确保数据格式适合微调。

使用ChatGPT进行数据预标注

HumanSignal驻地数据科学家Jimmy Whitaker在Towards Data Science上分享了一个利用AI训练AI的高效技巧 - 使用GPT-4引导标注:一种经济高效的数据标注方法。

一种经济高效的数据标注策略可以利用GPT-4等先进语言模型来实现。该方法通过利用模型理解上下文并生成类人文本的能力对数据进行预标注,从而显著减少人工数据标注所需的时间和成本。

流程始于创建特定的提示词,用于引导模型生成所需的输出格式。例如,在情感分析任务中,可以设计提示词结构来引导模型将给定文本的情感分类为积极、消极或中性。随后可通过API接口生成模型的预测结果。

数据经过预标注后,可以导入数据标注工具进行审核。这种方法使审核流程更加高效,因为人工审核员只需验证或修正模型生成的标签,而无需从头开始创建。

然而,需要注意的是,虽然这种方法能大幅减少数据标注所需的人工工作量,但应注意避免向这些API发送敏感或隐私数据,以防潜在的数据泄露风险。

模型调整

数据准备就绪后,预训练模型会被调整以适配目标任务。这种调整涉及修改模型的参数和架构,以捕捉任务特有的细微差别和需求。调整过程可能包括冻结某些模型层以保留已学习的表征,同时微调后续层。或者根据任务复杂度及其与预训练目标的相似性,也可以对整个模型进行微调。

训练与优化

模型调整完成后,微调过程涉及在特定任务数据集上训练模型。在训练期间,通过反向传播和梯度下降等技术迭代更新模型参数,以最小化损失函数并提高模型在目标任务上的性能。关键是要仔细监控训练过程,调整超参数,并应用正则化技术以防止模型过拟合或欠拟合。

评估与迭代

在微调之后,在独立的验证数据集上评估模型性能至关重要。这一评估能深入了解模型的泛化能力以及在未见数据上的表现。根据评估结果,可能需要进行进一步的微调迭代,包括调整数据、模型架构或超参数,以提升模型性能。

遵循这些步骤并迭代微调模型,可以将通用的预训练模型转化为擅长特定任务的强大工具。微调开启了无限可能,让我们既能利用预训练模型丰富的知识和语言理解能力,又能根据独特需求进行定制。下一节中,我们将深入探讨微调的细节,并研究实现最佳效果的具体技术和最佳实践。

微调方法与技术

微调方法和技术提供了多种优化预训练模型以适应特定任务的技巧。在本节中,我们将探讨在微调过程中可采用的几种有效方法,以获得卓越的结果。理解和运用这些方法,可以让你根据需求定制模型,同时最大化其性能和效率。

- 小样本学习 - 小样本学习是一种针对数据稀缺或获取成本高昂场景的微调方法。它使模型能够从少量示例中学习,从而在数据有限的情况下快速适应新任务。通过利用可迁移的知识和泛化能力,小样本学习是资源受限场景中需要快速适应和高效性能任务的理想选择。

- 迁移学习 - 迁移学习是微调中广泛使用的方法论,通过利用从一项任务中获得的知识来解决不同但相关的任务。这种方法减少了对大量数据和计算能力的需求,因为模型可以利用预先掌握的语言理解和模式识别能力。当新任务与模型初始训练任务存在相似性时,迁移学习特别有效,能够实现高效的适应性和性能提升。

- 顺序微调 - 顺序微调是指让模型依次在多个相关任务上进行训练。这种方法使模型能够理解跨不同任务的细微语言模式,从而提升性能和适应能力。当模型需要学习多个相关任务时,顺序微调具有优势,因为它可以积累知识并针对语言理解的特定方面进行精细调整。

- 任务特定微调 - 任务特定微调旨在使预训练模型在特定任务上表现优异。虽然这种方法需要更多数据和时间,但可以带来任务上的高性能表现。任务特定微调专注于优化模型参数和架构,以针对性增强其能力。当特定任务的性能至关重要时,这种方法特别有价值。

- 多任务学习 - 多任务学习涉及同时针对多个任务训练模型。这种方法通过利用不同任务间的共享表示,提高了泛化能力和性能。模型学习捕捉共同特征和模式,从而实现更全面的语言理解。当任务相关时,多任务学习最为有效,共享知识能增强模型的学习能力和适应性。

- 适配器训练 - 适配器训练是一种可以在不干扰原始模型在其他任务上表现的情况下对特定任务进行微调的方法。该方法通过训练轻量级模块来实现,这些模块可以集成到预训练模型中,从而进行有针对性的调整。当需要高度保留预训练模型原始性能时,适配器训练是一个很好的选择,它能灵活高效地适应特定任务需求。

您可以通过探索和利用这些微调方法和技术,有效地定制预训练模型来解决特定任务。每种方法都提供了独特的优势和考量因素,使您能够根据具体需求优化性能、效率和适应性。在下一节中,我们将更深入地探讨微调的实施和实践方面,为您提供实现最佳结果的指导原则和最佳实践。

Label Studio如何助力LLM微调

Label Studio 是一款多功能数据标注工具,能极大助力于大型语言模型(LLMs)微调过程中所用数据的准备工作。以下是Label Studio提升数据标注效率的几种方式:

- 数据标注 - 微调LLMs需要特定任务的数据,通常以标注样本的形式存在。Label Studio允许您创建自定义标注任务,使您能够以最适合特定任务的方式标注数据。这可能涉及文本分类、命名实体识别或语义文本相似度。

- 多格式支持 - Label Studio支持多种数据类型,包括文本、图像、音频和视频。这种多功能性在处理LLM时非常有益,因为这些模型越来越多地用于涉及不同类型数据的多模态任务。

- 协作标注 - Label Studio Enterprise 支持协作标注功能,使多名标注人员能够更轻松地在同一数据集上协同工作。在为LLM微调准备大型数据集时,此功能特别有用,因为它可以实现工作负载分配,并有助于确保标注的一致性。

- 质量控制 - Label Studio Enterprise 提供了质量控制功能,如标注历史记录和分歧分析。这些功能有助于确保标注质量,这对微调过程的成功至关重要。

- 与机器学习模型集成 - Label Studio可以与机器学习模型集成,支持主动学习工作流。这意味着您可以使用LLM对数据进行预标注,再由人工标注员进行校正。这种方法可以提高标注效率,并改善微调结果。

Label Studio 能够提供工具来准备高质量、任务特定的数据集,用于微调大语言模型。通过促进高效准确的数据标注,Label Studio 可以帮助您充分释放大语言模型的潜力。