完整性、准确性、一致性:机器学习中保持数据质量的三大关键

机器学习模型的效果仅取决于其训练数据。如果数据不完整或标注不当,模型的预测结果也会反映出这些缺陷。

但当项目进行到关键阶段时,如何识别并保持高质量数据?在机器学习语境中,"数据质量"又意味着什么?

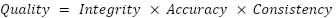

从最高层面来看,您可以通过将"数据质量"提炼为三个关键特征来简化这个问题的答案:完整性、准确性和一致性。

- 完整性:您所使用的数据集的可靠性

- 准确率:标注结果的有效性和正确性程度

- 一致性:数据集中标注结果之间的一致程度

将每个因素视为贯穿整个标注流程的数据质量维护高级路线图的一部分。

1. 完整性:检查数据集中的常见错误

在验证您使用的数据源完整且具有代表性后,请检查确保您的数据集没有常见错误,如缺失值、重复值和异常值。

缺失数据

流式数据管道在机器学习中很受欢迎,因为它们能为模型提供新鲜的实时数据,使模型能够反映数据的变化。虽然流式数据是提升模型质量的有效方式,但它也存在一个缺点:会增加数据在传输过程中被损坏或完全丢失的概率。

这就是为什么在流水线的这一阶段开始验证数据质量非常重要。在标注前检查缺失和损坏的数据样本可以避免后续的大量麻烦。当你发现损坏的样本时,可以手动输入缺失值,或者直接从训练数据中移除该样本。

重复数据

数据重复是数据准备过程中另一个常见错误。当数据集中存在重复项时,可能导致数据分布不当,从而影响整个模型的准确性。至少,重复数据会增加标注成本,因为标注人员需要重复执行相同的工作。

数据异常值

数据异常值是指那些显著偏离数据集统计特征的数值。如果它们在数据集中占比过高,可能会影响模型性能。为了降低异常值扭曲训练数据的可能性,在评估数据集质量时,应定位并隔离这些异常值。

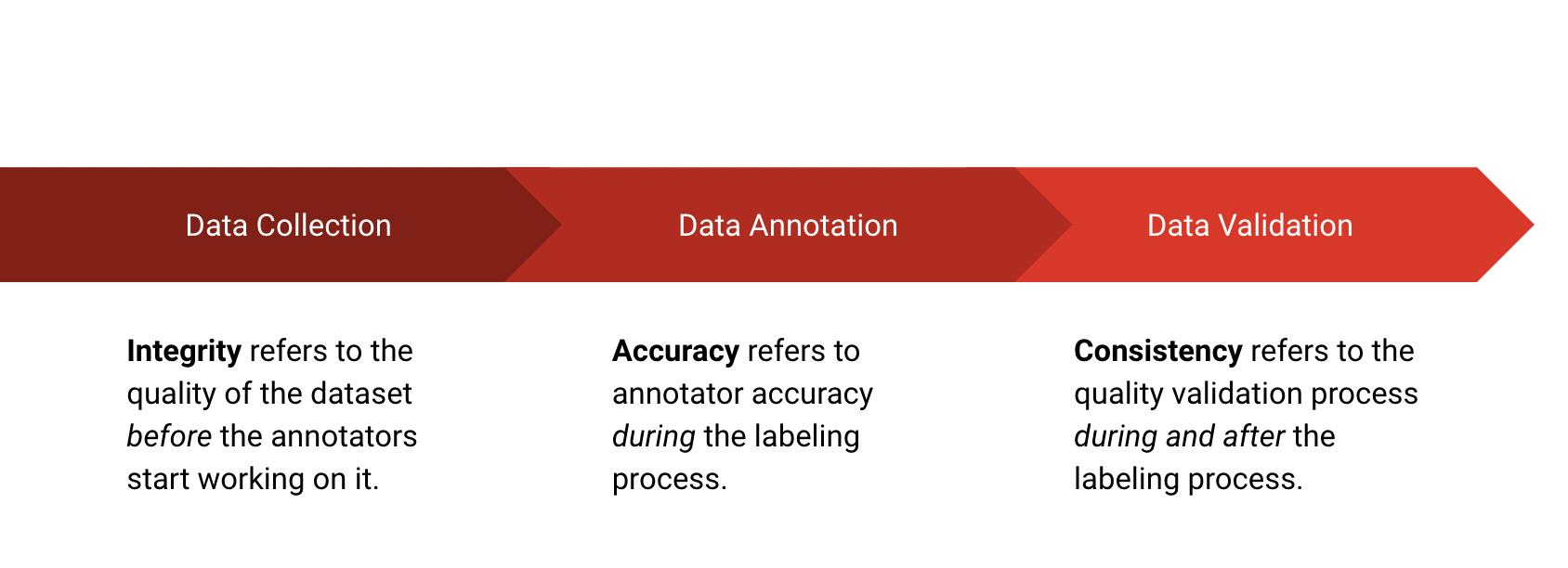

2. 准确性:验证标注数据

Ground Truth Accuracy(真实准确率)是衡量数据集准确性的最简单方法。

基准真值(Ground Truth)是在项目开始前创建的一组预定义标注。它们帮助模型理解您期望的结果是什么样子的。如果提供足够的基准真值数据,模型就能学习到驱动结果的内在模式。

真实准确度是标注者答案与真实数据之间的直接对比。差异通常以0-1的系数表示,其中>0.9被视为可接受的准确度范围。

虽然简单直接,但Ground Truth准确性并非没有缺点。如果Ground Truth标注未经过筛选以反映项目实际预期的数据分布,就可能出现抽样偏差。当项目从流行的标注数据集或其他外部标注来源借用Ground Truth数据时,这是一个常见错误。

如何提高基准真值的准确性

如果您的标注结果与真实情况准确率较低,且已排除抽样偏差,最可能的原因是标注指南存在问题。低分意味着标注人员无法理解任务要求,因此首要解决方法是修订并明确说明标注指引。之后,直接与标注人员沟通,共同完成一些示例标注。如果标注人员仍有疑问,持续优化指南直至所有问题得到解决。

您也可以考虑将任务拆分为更小、更易于理解的子任务。如果之后问题仍然存在,就该寻找在您的模型所涉及领域具有专业知识的标注人员了。

3. 一致性:寻找标注者共识

准确性和一致性相互促进:如果标签应用不一致,准确性就不能作为衡量质量的有效标准;同样,如果标签不准确,一致性也无法有效衡量质量。二者共同构成了数据质量的黄金标准。

当您比较同一标注的不同版本且答案一致时,数据就是一致的。

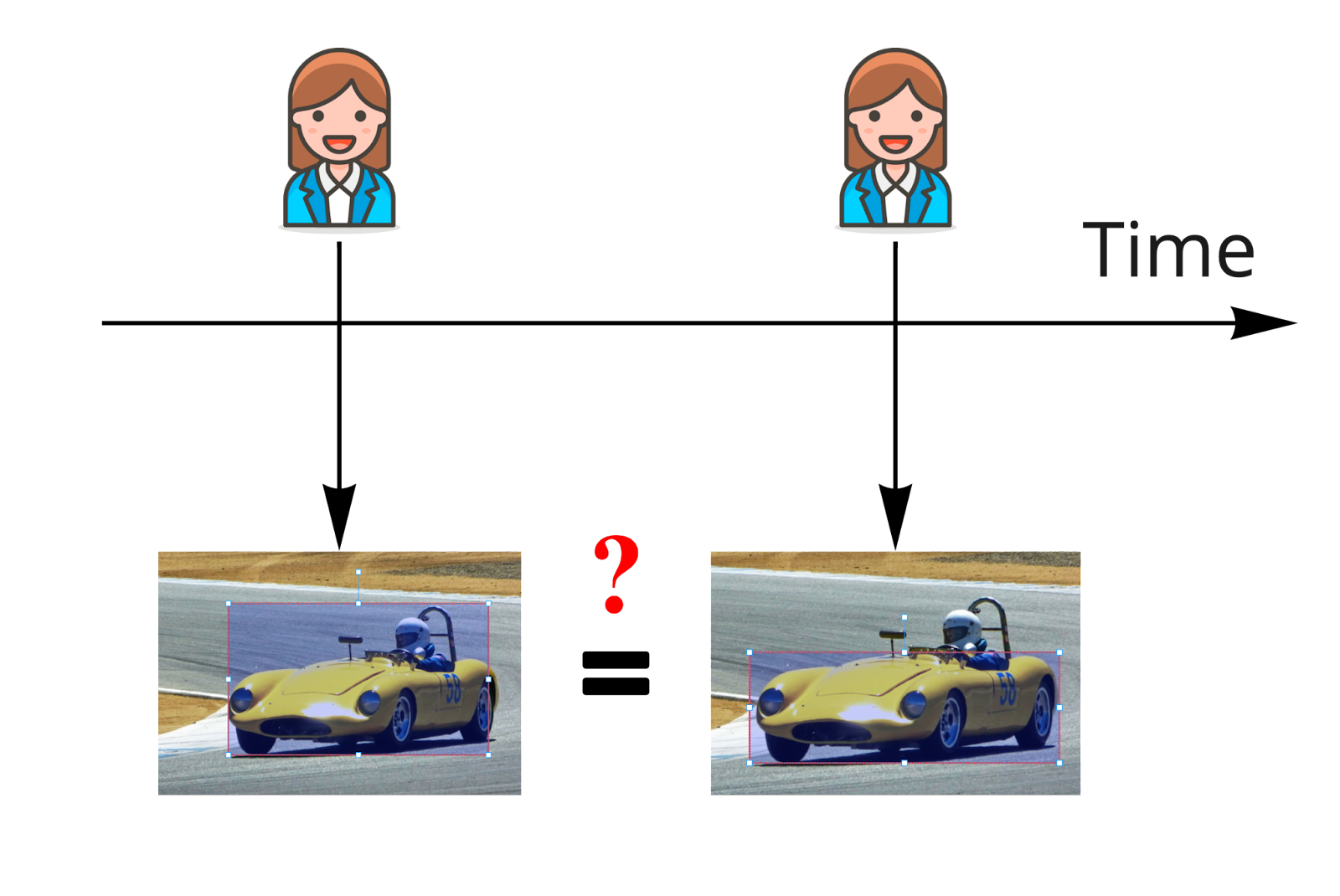

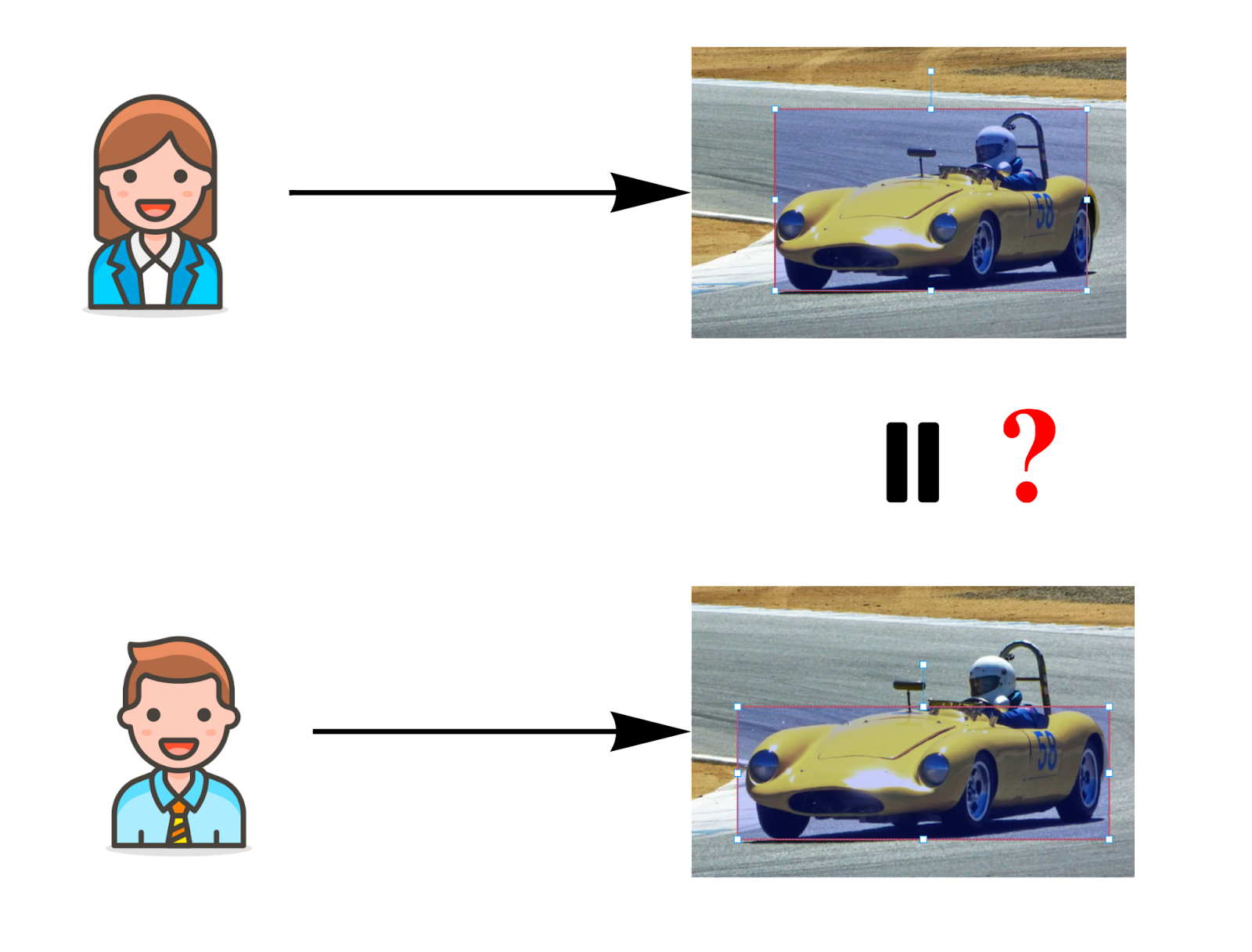

对于模型训练来说,两种一致性至关重要:随时间变化的一致性,通过标注者内部一致性来衡量;以及标注者之间的一致性,通过标注者间一致性来衡量。

- 标注者内部一致性(IAC)用于衡量标注者随时间变化的可靠性。为追踪IAC指标,需定期将相同样本发送给同一批标注者,并计算新标注结果与先前相同任务标注结果之间的一致率。

- 标注者间一致性(IAA)用于衡量不同标注者之间的共识程度。要追踪IAA指标,需要让两个或更多标注者对同一个样本进行标注,然后计算他们达成一致的比率。

标注者内部一致性:

标注者间一致性:

如何提高标注一致性

如果您注意到AIC值较低(意味着标注者个体随时间推移的自一致性较低),请考虑标注者在连续样本之间收到的反馈。如果标注者随着每轮反馈学习到更多内容,那么您可以认为他们后期的回答更可靠。可以舍弃早期的标注结果。

为了避免这个问题,在项目开始时与标注人员一起完成多个示例——直到他们的一致性随时间稳定下来后,再让他们自由处理数据。

对于IAC和IAA来说,低一致性分数表明数据集中可能存在潜在问题。要诊断这个问题,首先需要检查单个标注。有时你只是获得了模糊或异常的数据,这些数据可以安全地丢弃。其他时候,你可能会发现混淆点并澄清你的标注说明。

使用Label Studio提升机器学习数据质量

在训练数据中保持完整性、准确性和一致性可能非常简单,也可能在逻辑上完全无法实现。

关键区别在哪里?一切都取决于您的数据标注工具。从定义用户角色到置信度标记和共识功能,Label Studio让大规模验证数据质量变得轻而易举。