torch.utils.tensorboard¶

在继续之前,可以在 https://www.tensorflow.org/tensorboard/找到更多关于TensorBoard的详细信息。

一旦你安装了 TensorBoard,这些工具允许你将 PyTorch 模型和指标记录到一个目录中,以便在 TensorBoard UI 中进行可视化。标量、图像、直方图、图表和嵌入可视化都支持 PyTorch 模型和张量,以及 Caffe2 网络和 blob。

SummaryWriter 类是您的主要入口,用于记录数据以供 TensorBoard 消费和可视化。例如:

import torch

import torchvision

from torch.utils.tensorboard import SummaryWriter

from torchvision import datasets, transforms

# 默认情况下,Writer 将输出到 ./runs/ 目录

writer = SummaryWriter()

transform = transforms.Compose([transforms.ToTensor(), transforms.Normalize((0.5,), (0.5,))])

trainset = datasets.MNIST('mnist_train', train=True, download=True, transform=transform)

trainloader = torch.utils.data.DataLoader(trainset, batch_size=64, shuffle=True)

model = torchvision.models.resnet50(False)

# 让 ResNet 模型接受灰度图像而不是 RGB 图像

model.conv1 = torch.nn.Conv2d(1, 64, kernel_size=7, stride=2, padding=3, bias=False)

images, labels = next(iter(trainloader))

grid = torchvision.utils.make_grid(images)

writer.add_image('images', grid, 0)

writer.add_graph(model, images)

writer.close()

这可以通过 TensorBoard 进行可视化,TensorBoard 应该可以通过以下命令安装并运行:

pip install tensorboard

tensorboard --logdir=runs

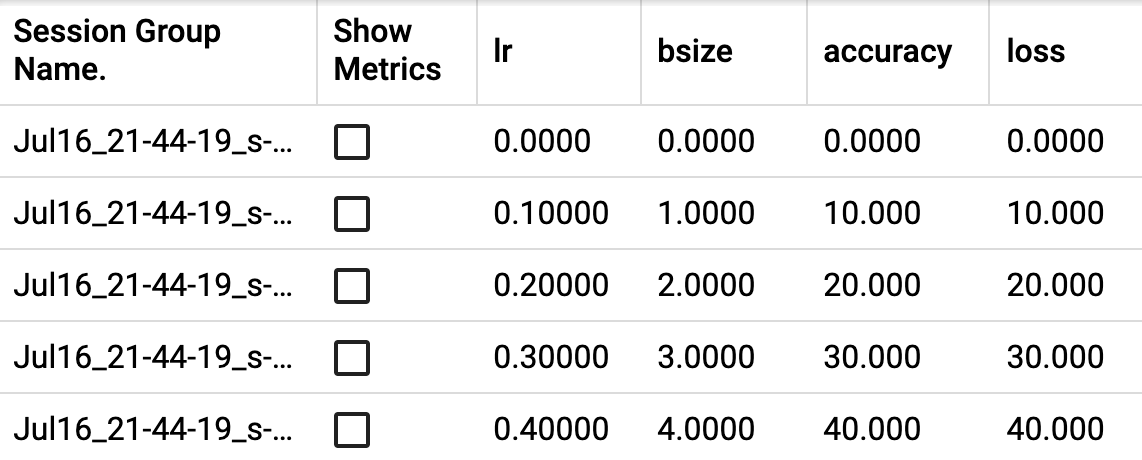

一个实验可以记录大量的信息。为了避免界面混乱并获得更好的结果聚类,我们可以通过分层命名来对图表进行分组。例如,“Loss/train” 和 “Loss/test” 将会被分组在一起,而 “Accuracy/train” 和 “Accuracy/test” 则会在 TensorBoard 界面中分别分组。

from torch.utils.tensorboard import SummaryWriter

import numpy as np

writer = SummaryWriter()

for n_iter in range(100):

writer.add_scalar('Loss/train', np.random.random(), n_iter)

writer.add_scalar('Loss/test', np.random.random(), n_iter)

writer.add_scalar('Accuracy/train', np.random.random(), n_iter)

writer.add_scalar('Accuracy/test', np.random.random(), n_iter)

预期结果:

- class torch.utils.tensorboard.writer.SummaryWriter(log_dir=None, comment='', purge_step=None, max_queue=10, flush_secs=120, filename_suffix='')[源代码]¶

将条目直接写入日志目录中的事件文件,供 TensorBoard 使用。

The SummaryWriter 类提供了一个高级API,用于在指定目录中创建事件文件,并向其中添加摘要和事件。该类异步更新文件内容。这允许训练程序直接从训练循环中调用方法向文件添加数据,而不会减慢训练速度。

- __init__(log_dir=None, comment='', purge_step=None, max_queue=10, flush_secs=120, filename_suffix='')[源代码]¶

创建一个SummaryWriter,用于将事件和摘要写入事件文件。

- Parameters

log_dir (str) – 保存目录位置。默认是 runs/CURRENT_DATETIME_HOSTNAME,每次运行后都会更改。 使用分层文件夹结构可以轻松比较 不同运行之间的差异。例如,为每个新实验传递 ‘runs/exp1’, ‘runs/exp2’ 等,以便在它们之间进行比较。

评论 (str) – 评论日志目录后缀附加到默认的

log_dir。如果log_dir被赋值,此参数无效。purge_step (int) – 当日志在步骤 崩溃并在步骤 重新启动时, 任何 global_step 大于或等于 的事件将被 清除并从 TensorBoard 中隐藏。 请注意,崩溃和恢复的实验应具有相同的

log_dir。max_queue (int) – 在调用其中一个‘add’方法强制刷新到磁盘之前,待处理事件和摘要的队列大小。默认是十个项目。

flush_secs (int) – 每隔多少秒将挂起的事件和摘要刷新到磁盘。默认是每两分钟一次。

filename_suffix (str) – 在 log_dir 目录中所有事件文件名后添加的后缀。有关文件名构造的更多详细信息,请参阅 tensorboard.summary.writer.event_file_writer.EventFileWriter。

示例:

from torch.utils.tensorboard import SummaryWriter # 创建一个带有自动生成文件夹名称的摘要写入器。 writer = SummaryWriter() # 文件夹位置: runs/May04_22-14-54_s-MacBook-Pro.local/ # 使用指定的文件夹名称创建一个摘要写入器。 writer = SummaryWriter("my_experiment") # 文件夹位置: my_experiment # 创建一个带有附加注释的摘要写入器。 writer = SummaryWriter(comment="LR_0.1_BATCH_16") # 文件夹位置: runs/May04_22-14-54_s-MacBook-Pro.localLR_0.1_BATCH_16/

- add_scalar(tag, scalar_value, global_step=None, walltime=None, new_style=False, double_precision=False)[源代码]¶

将标量数据添加到摘要中。

- Parameters

示例:

from torch.utils.tensorboard import SummaryWriter writer = SummaryWriter() x = range(100) for i in x: writer.add_scalar('y=2x', i * 2, i) writer.close()

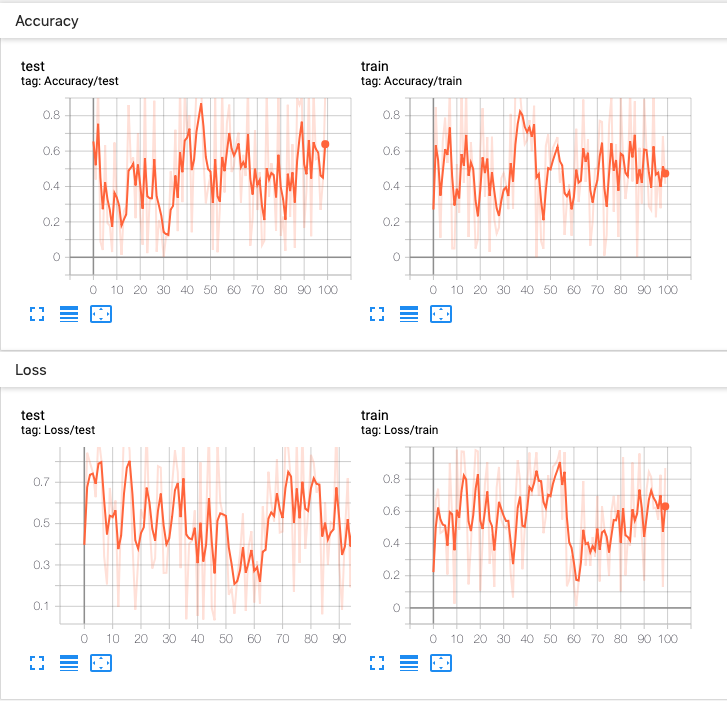

预期结果:

- add_scalars(main_tag, tag_scalar_dict, global_step=None, walltime=None)[源代码]¶

将多个标量数据添加到摘要中。

- Parameters

示例:

from torch.utils.tensorboard import SummaryWriter writer = SummaryWriter() r = 5 for i in range(100): writer.add_scalars('run_14h', {'xsinx':i*np.sin(i/r), 'xcosx':i*np.cos(i/r), 'tanx': np.tan(i/r)}, i) writer.close() # 此调用将三个值添加到具有标签的相同标量图中 # 'run_14h' 在 TensorBoard 的标量部分。

预期结果:

- add_histogram(tag, values, global_step=None, bins='tensorflow', walltime=None, max_bins=None)[源代码]¶

将直方图添加到摘要中。

- Parameters

标签 (str) – 数据标识符

值 (torch.Tensor, numpy.ndarray, 或 字符串/blob名称) – 用于构建直方图的值

global_step (int) – 要记录的全局步数值

bins (str) – 可以是 {‘tensorflow’,’auto’, ‘fd’, …} 之一。这决定了如何创建区间。您可以在以下链接中找到其他选项:https://docs.scipy.org/doc/numpy/reference/generated/numpy.histogram.html

walltime (float) – 可选的覆盖默认walltime(time.time()) 自事件纪元以来的秒数

示例:

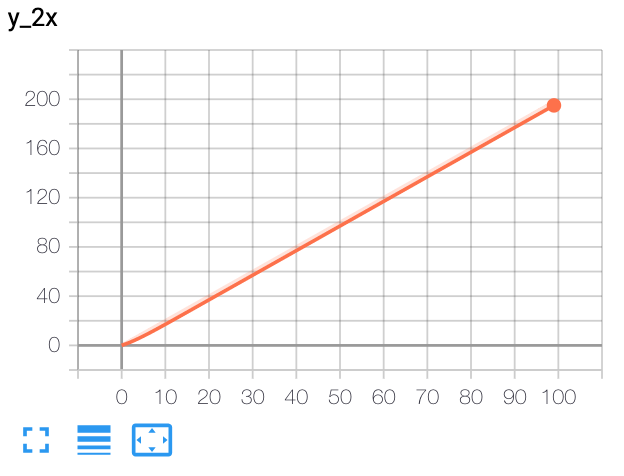

from torch.utils.tensorboard import SummaryWriter import numpy as np writer = SummaryWriter() for i in range(10): x = np.random.random(1000) writer.add_histogram('分布中心', x + i, i) writer.close()

预期结果:

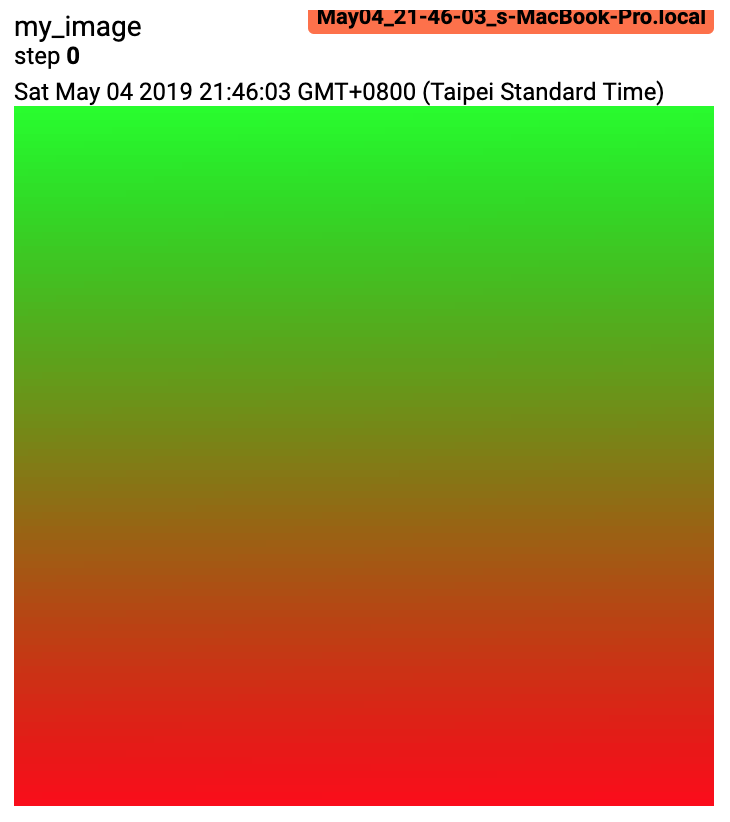

- add_image(tag, img_tensor, global_step=None, walltime=None, dataformats='CHW')[源代码]¶

将图像数据添加到摘要中。

请注意,这需要

pillow包。- Parameters

标签 (str) – 数据标识符

img_tensor(torch.Tensor,numpy.ndarray,或字符串/blob名称)– 图像数据

global_step (int) – 要记录的全局步数值

walltime (float) – 可选的覆盖默认walltime(time.time()) 事件发生后的纪元秒数

dataformats (str) – 图像数据格式规范,形式为 CHW, HWC, HW, WH等。

- Shape:

img_tensor: 默认是 . 你可以使用

torchvision.utils.make_grid()将一批张量转换为 3xHxW 格式,或者调用add_images让我们来完成这项工作。 具有 , , 的张量也是合适的,只要 传递相应的dataformats参数,例如CHW,HWC,HW。

示例:

from torch.utils.tensorboard import SummaryWriter import numpy as np img = np.zeros((3, 100, 100)) img[0] = np.arange(0, 10000).reshape(100, 100) / 10000 img[1] = 1 - np.arange(0, 10000).reshape(100, 100) / 10000 img_HWC = np.zeros((100, 100, 3)) img_HWC[:, :, 0] = np.arange(0, 10000).reshape(100, 100) / 10000 img_HWC[:, :, 1] = 1 - np.arange(0, 10000).reshape(100, 100) / 10000 writer = SummaryWriter() writer.add_image('my_image', img, 0) # 如果你有非默认的维度设置,请设置 dataformats 参数。 writer.add_image('my_image_HWC', img_HWC, 0, dataformats='HWC') writer.close()

预期结果:

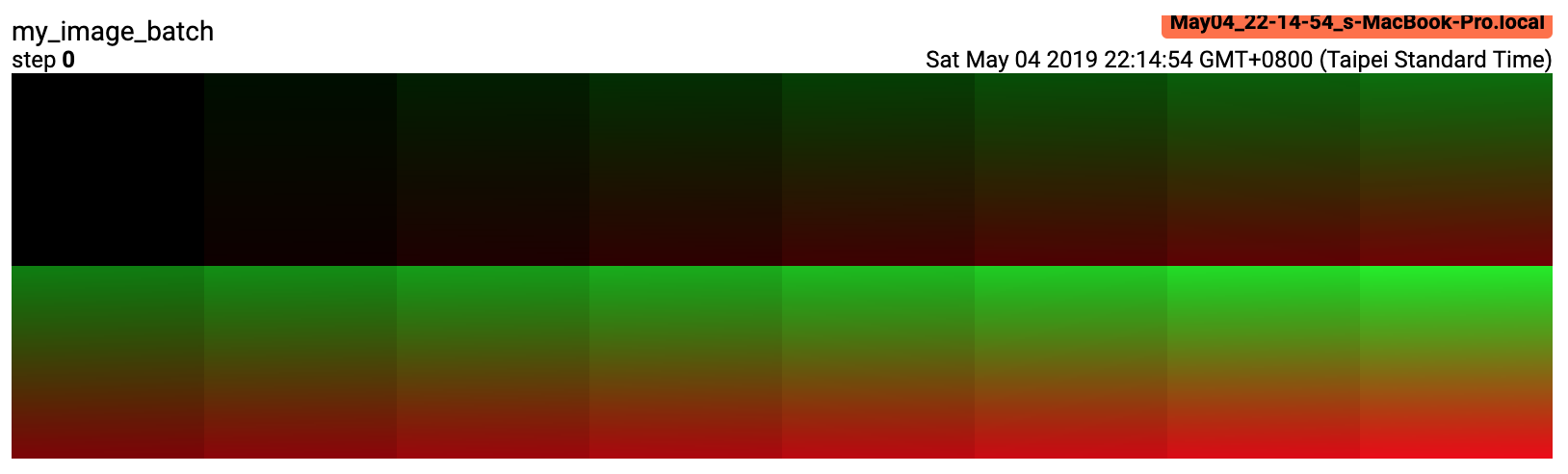

- add_images(tag, img_tensor, global_step=None, walltime=None, dataformats='NCHW')[源代码]¶

将批量图像数据添加到摘要中。

请注意,这需要

pillow包。- Parameters

标签 (str) – 数据标识符

img_tensor(torch.Tensor,numpy.ndarray,或字符串/blob名称)– 图像数据

global_step (int) – 要记录的全局步数值

walltime (float) – 可选的覆盖默认walltime(time.time()) 事件发生后的纪元秒数

dataformats (str) – 图像数据格式规范,形式为 NCHW, NHWC, CHW, HWC, HW, WH等。

- Shape:

img_tensor: 默认是 . 如果指定了

dataformats,则可以接受其他形状。例如 NCHW 或 NHWC。

示例:

from torch.utils.tensorboard import SummaryWriter import numpy as np img_batch = np.zeros((16, 3, 100, 100)) for i in range(16): img_batch[i, 0] = np.arange(0, 10000).reshape(100, 100) / 10000 / 16 * i img_batch[i, 1] = (1 - np.arange(0, 10000).reshape(100, 100) / 10000) / 16 * i writer = SummaryWriter() writer.add_images('my_image_batch', img_batch, 0) writer.close()

预期结果:

- add_figure(tag, figure, global_step=None, close=True, walltime=None)[源代码]¶

将 matplotlib 图形渲染为图像并添加到摘要中。

请注意,这需要

matplotlib包。

- add_video(tag, vid_tensor, global_step=None, fps=4, walltime=None)[源代码]¶

将视频数据添加到摘要中。

请注意,这需要

moviepy包。- Parameters

- Shape:

vid_tensor: . 值应位于 [0, 255] 对于类型 uint8 或 [0, 1] 对于类型 float。

- add_audio(tag, snd_tensor, global_step=None, sample_rate=44100, walltime=None)[源代码]¶

将音频数据添加到摘要中。

- Parameters

标签 (str) – 数据标识符

snd_tensor (torch.Tensor) – 声音数据

global_step (int) – 要记录的全局步数值

sample_rate (int) – 采样率,单位为赫兹

walltime (float) – 可选的覆盖默认walltime(time.time()) 事件发生后的纪元秒数

- Shape:

snd_tensor: 。值应在 [-1, 1] 之间。

- add_text(tag, text_string, global_step=None, walltime=None)[源代码]¶

将文本数据添加到摘要中。

- Parameters

示例:

writer.add_text('lstm', '这是一个lstm', 0) writer.add_text('rnn', '这是一个rnn', 10)

- add_graph(model, input_to_model=None, verbose=False, use_strict_trace=True)[源代码]¶

将图表数据添加到摘要中。

- Parameters

模型 (torch.nn.Module) – 要绘制的模型。

input_to_model (torch.Tensor 或 list 的 torch.Tensor) – 要输入的变量或变量元组。

verbose (bool) – 是否在控制台打印图结构。

use_strict_trace (bool) – 是否将关键字参数strict传递给torch.jit.trace。当你希望跟踪器记录你的可变容器类型(列表、字典)时,传递False。

- add_embedding(mat, metadata=None, label_img=None, global_step=None, tag='default', metadata_header=None)[源代码]¶

将嵌入投影仪数据添加到摘要中。

- Parameters

mat(torch.Tensor 或 numpy.ndarray)– 一个矩阵,其中每一行是数据点的特征向量

元数据 (列表) – 一个标签列表,每个元素将被转换为字符串

label_img (torch.Tensor) – 对应于每个数据点的图像

global_step (int) – 要记录的全局步数值

标签 (str) – 嵌入的名称

- Shape:

mat: , 其中 N 是数据的数量,D 是特征维度

label_img:

示例:

import keyword import torch meta = [] while len(meta)<100: meta = meta+keyword.kwlist # 获取一些字符串 meta = meta[:100] for i, v in enumerate(meta): meta[i] = v+str(i) label_img = torch.rand(100, 3, 10, 32) for i in range(100): label_img[i]*=i/100.0 writer.add_embedding(torch.randn(100, 5), metadata=meta, label_img=label_img) writer.add_embedding(torch.randn(100, 5), label_img=label_img) writer.add_embedding(torch.randn(100, 5), metadata=meta)

- add_pr_curve(tag, labels, predictions, global_step=None, num_thresholds=127, weights=None, walltime=None)[源代码]¶

添加精确召回曲线。

绘制精确召回曲线可以让您了解模型在不同阈值设置下的性能。通过此函数,您为每个目标提供真实标签(T/F)和预测置信度(通常是模型的输出)。TensorBoard UI将允许您交互式地选择阈值。

- Parameters

标签 (str) – 数据标识符

标签 (torch.Tensor, numpy.ndarray, 或 字符串/blob名称) – 真实数据。每个元素的二进制标签。

预测 (torch.Tensor, numpy.ndarray, 或 字符串/blob名称) – 元素被分类为真的概率。 值应在 [0, 1] 范围内

global_step (int) – 要记录的全局步数值

num_thresholds (int) – 用于绘制曲线的阈值数量。

walltime (float) – 可选的覆盖默认walltime(time.time()) 事件发生后的纪元秒数

示例:

from torch.utils.tensorboard import SummaryWriter import numpy as np labels = np.random.randint(2, size=100) # 二元标签 predictions = np.random.rand(100) writer = SummaryWriter() writer.add_pr_curve('pr_curve', labels, predictions, 0) writer.close()

- add_custom_scalars(layout)[源代码]¶

通过在‘scalars’中收集图表标签来创建特殊图表。

注意:此函数每个 SummaryWriter() 对象只能调用一次。

因为它只为tensorboard提供元数据,所以该函数可以在训练循环之前或之后调用。

- Parameters

布局 (字典) – {类别名称: 图表},其中 图表 也是一个字典 {图表名称: 属性列表}。属性列表 中的第一个元素是图表的类型 (多线 或 边距 之一),第二个元素应该是一个包含你在 add_scalar 函数中使用的标签的列表,这些标签将被收集到新的图表中。

示例:

layout = {'台湾':{'台湾证券交易所':['多线',['twse/0050', 'twse/2330']]}, '美国':{ '道琼斯':['边距', ['dow/aaa', 'dow/bbb', 'dow/ccc']], '纳斯达克':['边距', ['nasdaq/aaa', 'nasdaq/bbb', 'nasdaq/ccc']]}} writer.add_custom_scalars(layout)

- add_mesh(tag, vertices, colors=None, faces=None, config_dict=None, global_step=None, walltime=None)[源代码]¶

将网格或3D点云添加到TensorBoard。

该可视化基于 Three.js,因此允许用户与渲染的对象进行交互。除了顶点、面等基本定义外,用户还可以进一步提供相机参数、光照条件等。请查看 https://threejs.org/docs/index.html#manual/en/introduction/Creating-a-scene 以获取高级用法。

- Parameters

标签 (str) – 数据标识符

顶点 (torch.Tensor) – 顶点的3D坐标列表。

颜色 (torch.Tensor) – 每个顶点的颜色

faces (torch.Tensor) – 每个三角形内的顶点索引。(可选)

config_dict – 包含ThreeJS类名称和配置的字典。

global_step (int) – 要记录的全局步数值

walltime (float) – 可选的覆盖默认walltime(time.time()) 事件发生后的纪元秒数

- Shape:

顶点: . (批次, 顶点数量, 通道数)

颜色: 。值应在 [0, 255] 范围内,类型为 uint8 或 [0, 1] 范围内,类型为 float。

faces: . 这些值应在 [0, number_of_vertices] 范围内,类型为 uint8。

示例:

from torch.utils.tensorboard import SummaryWriter vertices_tensor = torch.as_tensor([ [1, 1, 1], [-1, -1, 1], [1, -1, -1], [-1, 1, -1], ], dtype=torch.float).unsqueeze(0) colors_tensor = torch.as_tensor([ [255, 0, 0], [0, 255, 0], [0, 0, 255], [255, 0, 255], ], dtype=torch.int).unsqueeze(0) faces_tensor = torch.as_tensor([ [0, 2, 3], [0, 3, 1], [0, 1, 2], [1, 3, 2], ], dtype=torch.int).unsqueeze(0) writer = SummaryWriter() writer.add_mesh('my_mesh', vertices=vertices_tensor, colors=colors_tensor, faces=faces_tensor) writer.close()

- add_hparams(hparam_dict, metric_dict, hparam_domain_discrete=None, run_name=None, global_step=None)[源代码]¶

在 TensorBoard 中添加一组要比较的超参数。

- Parameters

hparam_dict (字典) – 字典中的每个键值对是超参数的名称及其对应的值。 值的类型可以是 布尔、字符串、浮点数、 整数 或 None。

metric_dict (dict) – 字典中的每个键值对是指标的名称及其对应的值。请注意,此处使用的键在tensorboard记录中应是唯一的。否则,通过

add_scalar添加的值将在hparam插件中显示。在大多数情况下,这是不希望的。hparam_domain_discrete – (可选[Dict[str, List[Any]]])一个字典,包含超参数的名称及其可以持有的所有离散值

run_name (str) – 运行的名称,将作为logdir的一部分包含在内。如果未指定,将使用当前时间戳。

global_step (int) – 要记录的全局步数值

示例:

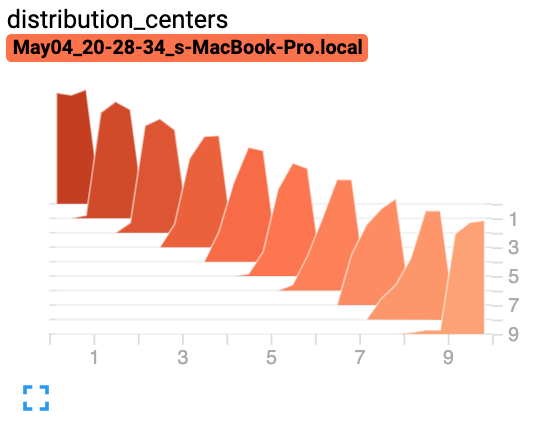

from torch.utils.tensorboard import SummaryWriter with SummaryWriter() as w: for i in range(5): w.add_hparams({'lr': 0.1*i, 'bsize': i}, {'hparam/accuracy': 10*i, 'hparam/loss': 10*i})

预期结果: