Hugging Face简介:一个宝贵的AI模型与工具目录

Hugging Face 是一个备受推崇的平台,被广泛认为是发现和利用语言模型(LLM)技术最有价值的资源之一。尽管它的名字有些有趣(以一个表情符号命名),Hugging Face 作为AI模型和工具的首要目录赢得了坚实的声誉。凭借其大量可随时用于微调的预训练模型集合,Hugging Face 为AI从业者和研究人员提供了一个全面的解决方案。

探索模型中心

在人工智能领域的前沿,Hugging Face的模型中心是一个资源库,截至2023年6月已拥有超过23万个预训练模型的惊人阵容。这些模型涵盖了广泛的尖端解决方案,包括FALCON、Alpaca和FLAN等知名模型,使用户能够获取最先进的资源来推进其人工智能应用。

Hugging Face的与众不同之处在于其用户友好的界面设计,旨在促进用户探索和理解其托管的模型。平台上展示的每个模型都配有全面的信息,让用户能够深入了解每个模型的架构细节、功能特性以及性能指标。关键细节如模型大小、下载次数和最后更新日期均被提供,使用户能够根据自身特定需求做出明智的模型选择决策。您还可以直接在Hugging Face网站上试用这些模型。

为何微调大语言模型至关重要

Out of the box, LLMs can handle general tasks fairly easily. But what do you do when you need to complete tasks that require more specialized knowledge than what LLMs typically have? You'll need to fine-tune the model by training it on your specific use case. This article is an excerpt from our ebook - The Essential Guide to Fine-Tuning LLMS. You can download the entire book here.

探索Hugging Face生态系统

强大的筛选与搜索工具

Hugging Face提供强大的筛选和排序功能,让用户能轻松浏览庞大的模型库。用户可以根据模型架构、任务领域、语言支持或特定性能指标等条件优化搜索,从而快速找到最符合功能需求和限制条件的理想模型。

社区协作与开放贡献

此外,Hugging Face的平台培育了一个充满活力的AI爱好者和专家社区。该平台使用户能够通过分享自己的模型以及对现有模型提供有价值的反馈和见解,为生态系统做出贡献。这种协作环境推动了平台上托管模型的持续进化和完善,确保用户能够获取AI研究的最新进展。

全AI生命周期的工具

除了模型中心外,Hugging Face还提供了一套全面的工具和实用程序来支持AI模型开发的整个生命周期。这些包括便于模型训练、微调、部署和评估的易用库和框架。Hugging Face的生态系统为从业者提供了必要的资源,以便在各种实际应用中高效开发和部署AI模型。

聚焦LLM排行榜

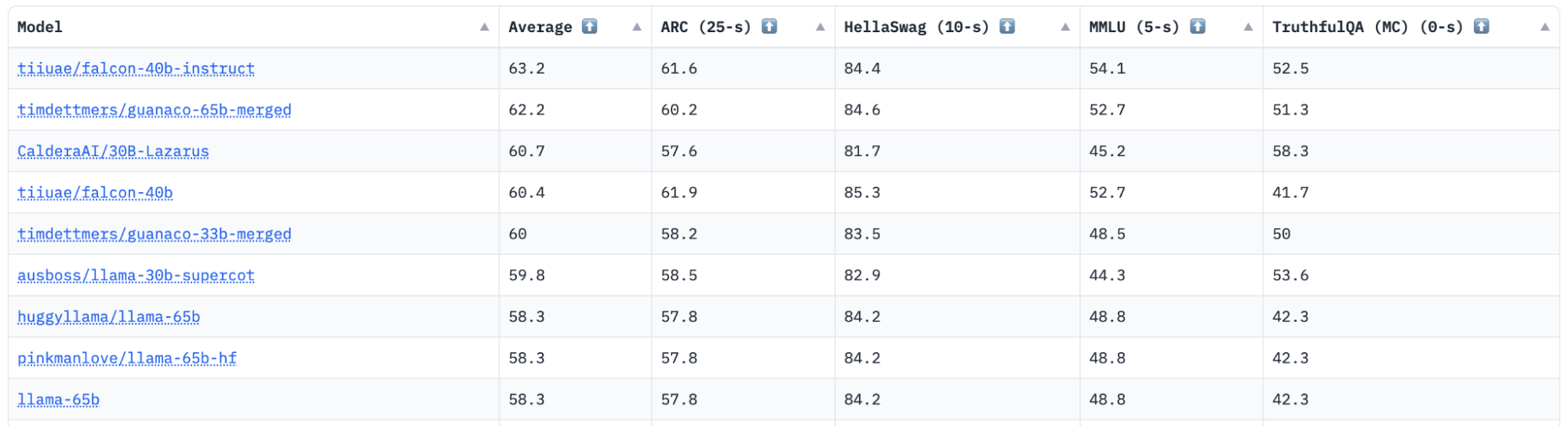

Hugging Face上最有用的工具之一是LLM排行榜。Open LLM排行榜是一个旨在追踪、排名和评估各种大型语言模型(LLMs)及聊天机器人性能的平台。该排行榜客观衡量了开源社区的进展,并帮助识别当前最先进的模型。

该排行榜的一个关键特性是对社区贡献的开放性。任何人都可以提交模型进行自动评估,前提是它是一个在Hub上拥有权重的Transformers模型。该平台还支持评估具有delta权重的非商业许可模型,例如LLaMa。

排行榜从两个主要方面评估模型:LLM基准测试以及人类与GPT-4评估。

- LLM基准测试在四个关键基准上评估模型:

- AI2推理挑战赛(25题) - 一套小学科学问题集。

- HellaSwag (10次尝试) - 一个常识推理测试,对人类来说很简单(约95%正确率),但对最先进的模型具有挑战性。

- MMLU (5-shot) - 一项用于衡量文本模型多任务准确性的测试。该测试涵盖57个任务,包括基础数学、美国历史、计算机科学、法律等领域。

- TruthfulQA (0-shot) - 一项测试,用于衡量模型重现网络上常见虚假信息的倾向性。

基准测试的选择旨在0样本和少样本设置下,测试跨多个领域的各种推理能力和通用知识。

人工 + GPT-4 评估

Evaluations 评估过程通过让人类评估员和GPT-4参与,基于一组保密的指令提示,对精选的流行开源大语言模型(LLMs)的输出结果进行比较。这些提示涵盖的任务包括头脑风暴、创意生成、常识推理、开放性问题回答、摘要总结和代码生成。人类评估员和模型都会使用1-8分的李克特量表对比较结果进行评分,每次评估都必须表达偏好倾向。这些偏好数据随后被用于建立自助法Elo排名。

与Scale AI的合作促进了在其平台上使用专业数据标注团队生成完成项,遵循提供的标注说明。还利用GPT-4通过特定提示来标注这些完成项,以获取评估流行模型的洞见。

Hugging Face LLM 排行榜

Hugging Face是AI社区不可或缺的资源,它提供了一个强大且用户友好的平台,用于访问海量预训练模型集合。其Model Hub托管了超过23万个模型,直观的界面和强大的搜索功能使用户能够轻松浏览并选择适合其特定AI任务的理想模型。凭借其协作生态系统和全面的工具套件,Hugging Face始终处于AI研究和开发的前沿,支持最先进语言模型的发展,并推动该领域的创新。