使用Label Studio优化RAG管道

使用Label Studio优化RAG管道

检索增强生成(RAG)管道通过使大型语言模型(LLMs)能够实时检索上下文数据并为终端用户生成更相关的响应而广受欢迎。在知识库极其庞大且动态变化的场景中,如客户支持、内容生成和实时数据分析,RAG管道尤其具有优势。

尽管RAG管道具有显著优势,但它们并非没有局限性,特别是在精确性、冲突数据源、复杂查询以及适应动态数据环境方面。优化RAG系统的可靠性和效率已成为数据科学团队的核心关注点。

为了展示使用Label Studio优化RAG管道的三种方法,我们围绕一个示例问答(QA)系统和RAG管道构建了一系列教程。我们将提供详细的步骤和代码示例来构建该系统并实现这三种方法。但在本文中,我们将首先介绍基本的RAG管道结构以及这三种方法的概述:

RAG管道结构概述

首先,让我们快速了解一下RAG系统的结构以及需要标注的部分。

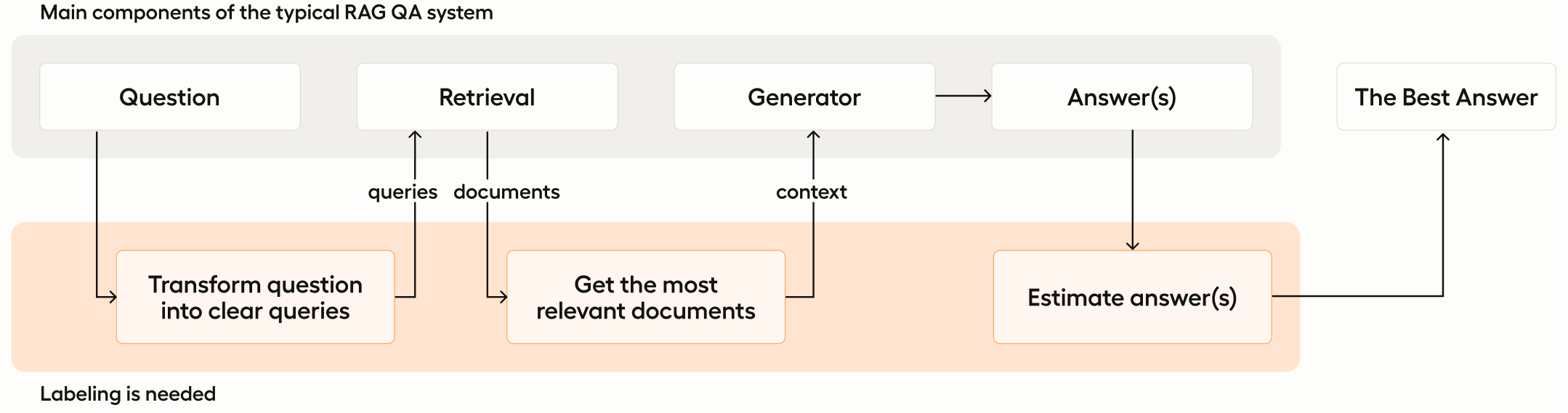

如前所述,我们将构建的简单RAG系统包含两个主要组件——检索器和生成器。该系统设计用于接收问题形式的输入,并将该问题转换为查询,然后传递给检索组件。检索系统随后利用该查询识别并提取与查询相关的文档,将其返回给生成器组件,最终生成问题的答案。

在这个RAG管道结构中,有几种方法可以通过人工监督和标注来提高模型结果的质量:

- 您可以优化用户查询以更好地适应您的领域,包括将复杂问题分解为更简单、可操作的查询以实现多步推理,并对问题进行分类以聚焦搜索或定制预处理方法

- 您可以通过在搜索后对文档进行重新排序来提升嵌入搜索的质量,优先展示最相关的文档,从而简化上下文

- 您可以根据知识库中精选的上下文来精心设计响应

提升RAG管道性能的方法

在深入探讨之前,需要指出的是RAG问答应用和聊天机器人可能相当复杂,通常需要设计精密的流程管道。Label Studio灵活的标注配置使其非常适合评估这些模型和流程。因此,基于上文讨论的典型RAG架构,我们将探讨三种利用Label Studio优化RAG流程的方法。

| 优化用户查询 | 提升文档搜索质量 | 控制生成答案 | |

| 目的 | 通过澄清、改写和分解来提升用户查询的清晰度和相关性 | 通过微调嵌入和重新排序来提高检索文档的准确性和相关性 | 确保生成答案的质量和适当性 |

| 训练样本需求 | 使用文本查询标注清理/重述的问题 | 来自相关性评分文档的正例和困难负例文档对 | 使用文本分类、评分量表和文本摘要进行标注的分类和排序响应 |

| 人工监督角色 | 标注员清理、优化和验证用户查询 | 标注员判断和排序领域特定数据集的文档相关性 | 标注员评估和评分LLM生成的响应 |

| 使用的Label Studio配置 | 清理并重新表述的查询 | 正面和困难负面示例 | 分类、评分、答案排序、文本摘要 |

| 标注复杂度 | 中等:需要理解领域术语 | 高:需要深入理解领域和产品 | 可变:取决于使用的方法 |

1. 优化用户查询

优化用户查询涉及分析和改进用户提供的初始问题或提示,以确保其清晰、具体且符合信息需求。明确精准的查询有助于RAG系统更好地理解用户意图,从而提升整体性能和用户满意度。这可能包括重写模糊查询、将复杂问题拆分为更简单的组成部分,或提供示例引导用户构建查询。

优化用户问题通常有三种典型方法。

- 说明:您可以清理原始问题,使其更清晰并与知识库的术语保持一致。

- 改写:将问题修改为类似的查询,以更好地匹配知识库。

- 分解:将一个复杂问题拆分为多个较小的查询,以提高文档检索效果。

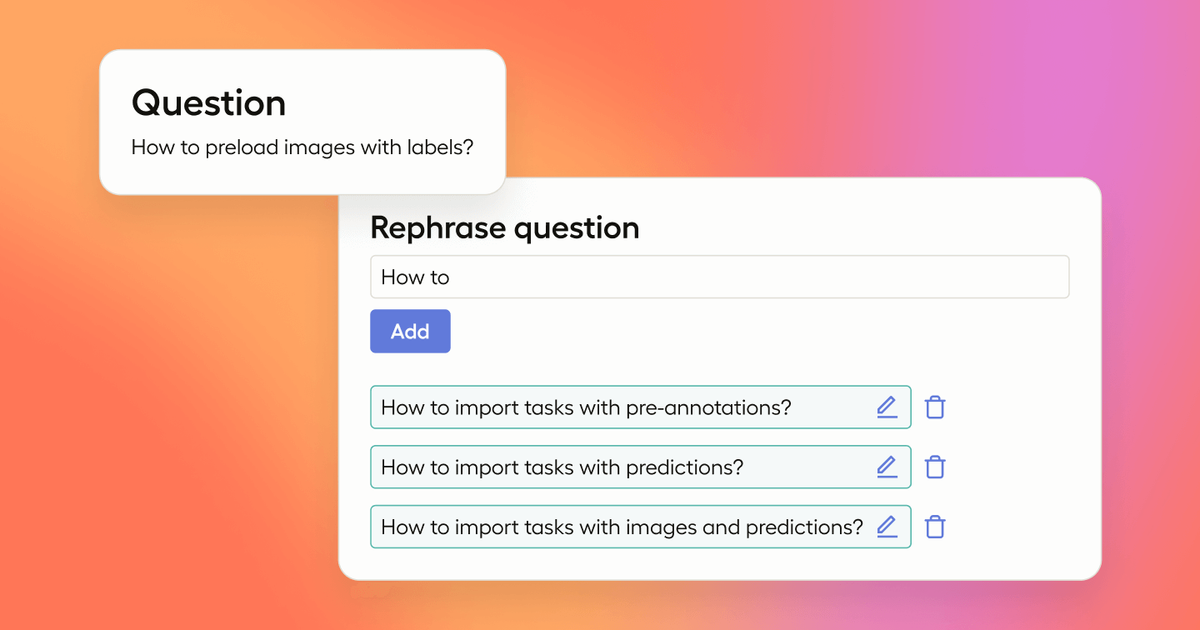

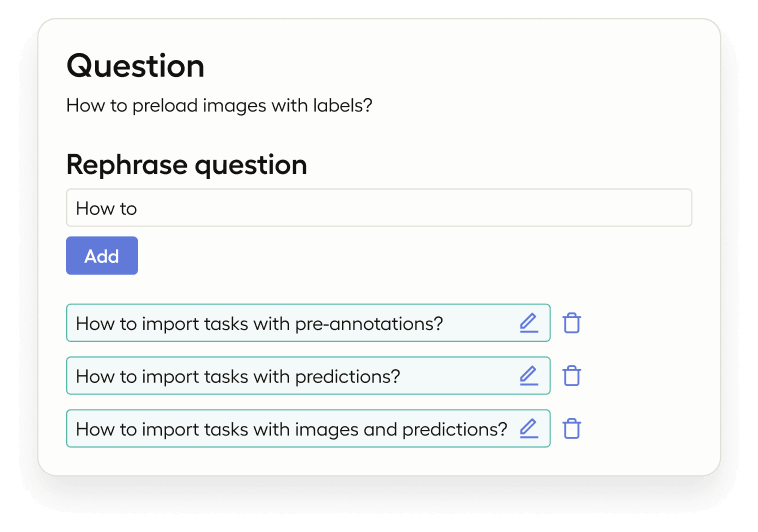

为了解决这些问题,您可以向语言模型展示如何重新表述原始问题,或为此目的对语言模型进行微调,但要获得最佳准确性需要训练示例。Label Studio通过特定的标注配置和任务示例支持这一过程。输入是用户的问题,标注则是问题的清理版本,也可能是多个重新表述的文本查询。

2. 提升文档搜索质量

提升文档搜索质量的重点在于增强RAG流程中的检索环节。这需要建立反馈机制,以确保每次查询都能获取最相关且高质量的文档。

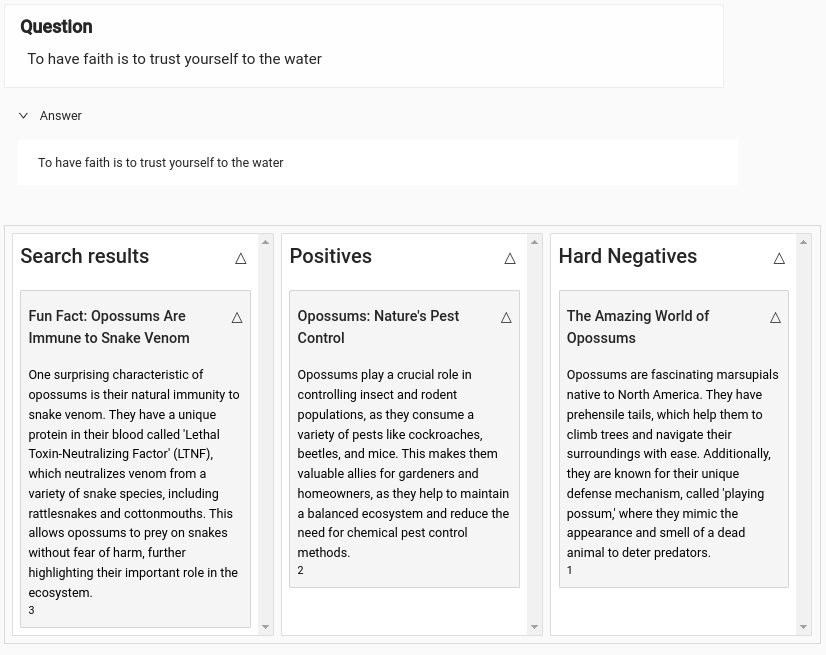

虽然嵌入技术功能强大,但并非完美无缺。为了从RAG流程中提取与用户查询最相关的文档,您可以针对特定领域微调嵌入模型。此外,对搜索结果进行重新排序能确保最相关的文档优先显示。该过程需要一个包含正样本和困难负样本的强健训练数据集,这些数据对于使用triplet-loss function进行训练至关重要。

请参考分步教程中的代码示例,使用Cohere重新排序模型提升RAG文档搜索质量。

3. 控制生成答案

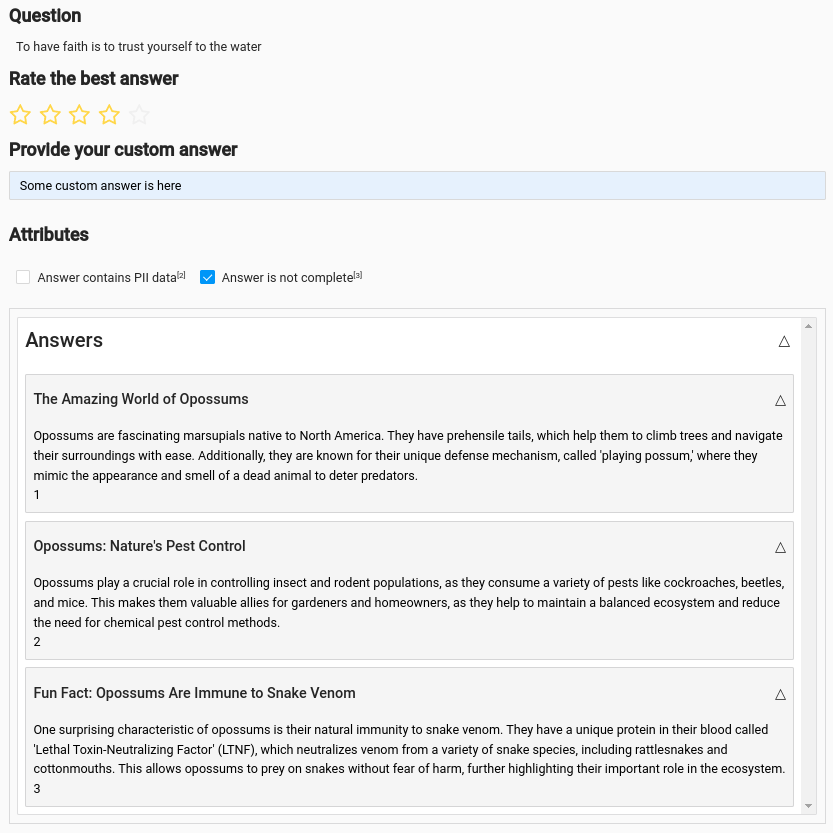

控制生成答案涉及实施机制来审查和优化生成模型产生的响应。Label Studio 在此过程中可以发挥关键作用,提供管理和评估生成响应质量的工具,包括:

- 分类回答: 这有助于通过将响应分类到Label Studio分类中来衡量系统性能。

- 评分分配:标注人员可以对答案进行评分(例如1-5星),提供关于答案质量的量化反馈Label Studio Rating。

- 答案排序:在使用多个LLM模型或方法的场景中,可以对答案进行排序以确定哪个模型表现最佳 Label Studio Answer Ranking。

- 手动撰写答案:对于需要更精确或定制化回复的情况,标注人员可以手动编写答案 Label Studio Text Summarization。

Label Studio 可作为管理聊天机器人回复的高效审核工具,尤其在紧急情况需要人工核实时。例如,对GitHub问题的回复虽然可以接受较慢的响应时间,但仍可能受益于人工监督。当答案被审核时,可配置Label Studio的webhook来触发REVIEW_CREATED事件。若审核通过,系统将自动发布该答案。

结论

我们为您概述了问答系统中一个简单的RAG管道结构,以及人工标注可以帮助解决错误和提高准确性的三个领域。

在接下来的几周内,我们将发布实践教程,帮助您构建RAG流程,然后配置Label Studio来协助您使用这三种方法评估和改进模型及流程。

在学习教程的过程中,欢迎随时访问我们的Discourse社区,与其他Label Studio用户交流您的使用体验。